A área denominada Inteligência Artificial é um dos campos da ciência mais explorados na atualidade, estando presente em uma gama crescente de aplicações que vão desde o entretenimento (Risi e Togelius, 2017) à saúde (Esteva et al., 2017), passando por campos como segurança digital (Aljumah e Ahamad, 2016; Omar, Johari e Smith, 2017), entre inúmeros outros.

Sundar Pichai, CEO do Google desde 2015, afirmou recentemente em um discurso no Fórum Econômico Mundial de 2018 que a inteligência artificial é provavelmente a área mais importante na qual a humanidade já trabalhou, equiparando sua importância à eletricidade e ao fogo e declarando ainda que esta tecnologia é o coração do Google (Parker, 2018). Dave Coplin, Chief Envisioning Officer da Microsoft, afirmou no AI Summit de 2016, que a inteligência artificial é a tecnologia mais importante em que todos estão trabalhando no momento (Shead, 2016). Um das páginas (“What is Artificial Intelligence? - Amazon Web Services”, [s.d.]) do website da Amazon é dedicada à explicar o que é inteligência artificial, e deixa clara a importância do aprendizado de máquinas (machine learning), uma de suas subáreas, em algumas das competências essenciais da companhia.

Isso ajuda a entender a relevância do campo no modelo de negócios de algumas das maiores empresas do mundo, já que esse interesse é acompanhado por outras gigantes da tecnologia, como Apple e Facebook. Na contramão desse movimento, no entanto, observa-se uma escassa penetração dessas tecnologias na indústria de instrumentos virtuais, acompanhado de um baixo volume de pesquisas ne área; Um levantamento bibliográfico na base Scopus revela que trabalhos relacionados à utilização de redes neurais para a simulação de instrumentos musicais ainda são bastante escassos, a despeito do sucesso desta ferramenta em iniciativas afins.

O potencial de inovação nesse campo é sugerido pelo papel central (muitas vezes representando o estado da arte) que as redes neurais artificiais vêm desempenhando em áreas diretamente correlatas, com o campo de síntese de voz, ou ainda em campos menos obviamente relacionados, à exemplo dos grandes avanços na área de visão de computadores (computer vision), como a geração de imagens e vídeos.

Esses resultados estimulam a transposição de algumas dessas inovações para o contexto da síntese sonora, além do desenvolvimento de novas abordagens. Nesse contexto, o presente trabalho investiga, a partir de diferentes perspectivas, o potencial de aplicação dos recentes desenvolvimentos na área de redes neurais à modelagem de instrumentos acústicos, com vistas à síntese sonora em tempo real.

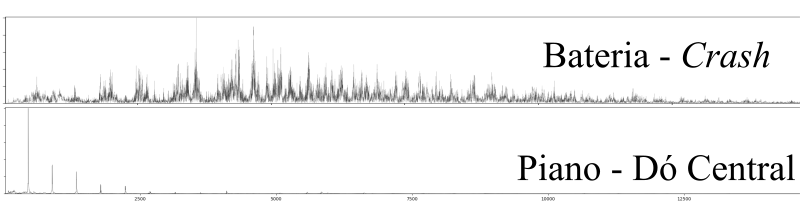

Ênfase é dada a instrumentos de caráter percussivo, no sentido de sistemas em que o som é gerado por uma excitação inicial, aproximadamente impulsiva do ponto de vista físico, e a subsequente vibração livre do(s) componentes pertinentes do instrumento. Esse é o caso, por exemplo, do conjunto de peças de uma bateria ao serem golpeados, das cordas ou conjuntos de cordas de um piano acionadas pelo martelo ao ser alavancado pelo pressionar das teclas e, em uma aproximação mais livre, a excitação causada pelos dedos ou palheta em instrumentos de corda.

Do ponto de vista da indústria, embora o interesse por instrumentos musicais digitais tenha crescido bastante na última década (Staudt, 2016), os instrumentos virtuais de ponta, utilizados em estúdios para gravações profissionais ainda baseiam-se prioritariamente em coleções de amostras sonoras pré-gravadas (Smith, 2008), demandando uma alta quantidade de memória em disco e razoável poder de processamento do hardware (em geral computadores) utilizado.

Em plataformas onde o poder de processamento e armazenamento são limitados, como é o caso de teclados digitais e baterias eletrônicas, por exemplo, é comum que esses instrumentos sejam guarnecidos com bibliotecas de menor tamanho e qualidade, suficientes apenas para a prática do instrumento; a qualidade de produção é alcançada apenas conectando-se o instrumento à um computador, e usando-o como controlador de um VST de forma a acessar técnicas de manipulação e coleções de amostras sonoras de melhor qualidade.

O foco em algoritmos neurais voltados à síntese em tempo real tem origem tanto na escassez de pesquisas sobre o tema quanto nas possibilidades mercadológicas: Aumentos de eficiência e redução do tamanho em memória ocupado pelo modelo podem, por exemplo, basear implementações mais verossímeis e baratas nessas plataformas dedicadas.

O objetivo geral deste trabalho é desenvolver um modelo de simulação em tempo real de instrumentos acústicos que tire proveito do estado da arte relacionado à redes neurais artificias para exibir maior eficiência, quando comparado aos algoritmos tradicionais, dando origem a simulações mais realistas, principalmente do ponto de vista da percepção humana, e menos intensivas computacionalmente.

Esse objetivo pode ser desmembrado em objetivos específicos:

Identificar formas compactas de representação das ondas sonoras mais adequadas à predição/generalização via redes neurais;

Identificar arquiteturas neurais que possam ser utilizadas na modelagem acústica;

Identificar na literatura sobre modelos acústicos de instrumentos musicais ferramentas que possam ser utilizadas para simplificação e aumento de eficiência, tanto do modelo quanto das representações;

Tendo em vista o foco na síntese em tempo real, identificar as arquiteturas e hiperparametros neurais e técnicas em geral mais eficientes,

Delinear a capacidade de generalização do modelo criado.

O trabalho limita-se à emulação de instrumentos musicais acústicos convencionais e não aborda, senão tangencialmente, a área mais subjetiva de desenho de novos instrumentos, através de um exemplo em que um instrumento híbrido é apresentado; um tratamento razoavelmente completo do tema, pelo grande número de possibilidades que oferece (Dalgleish, Spencer e Foster, 2014), está além do objetivo deste trabalho.

Adicionalmente, limitar o escopo do trabalho à investigação de instrumentos que possam ser aproximados por um modelo de excitação impulsivo, como aqui é feito, possibilita excluir da observação uma subárea significativa do processamento de sinais que lida com a evolução das frequências de uma onda sonora no domínio do tempo, trazendo o volume de pesquisa a níveis práticos, sem uma perda substancial em termos conceituais.

Uma outra vantagem desse recorte é de cunho técnico, já que essa escolha reduz a duração média das ondas investigadas; investigações do comportamento de arquiteturas neurais densas e profundas, por exemplo, tornam-se computacionalmente custosas quando uma dimensionalidade muito grande é envolvida. Esse também é o comportamento de alguns dos algoritmos utilizados durante o trabalho, como a Transformada Discreta de Fourier.

Em relação ao tratamento das redes neurais, prioridade foi dada às arquiteturas já consolidadas na literatura, o que excluiu, por exemplo, uma investigação da promissora arquitetura Capsnet (Hinton, Sabour e Frosst, 2018; Sabour, Frosst e Hinton, 2017). A escolha é necessária devido à limitações de tempo frente ao grande volume de pesquisas envolvendo novas arquiteturas.

Durante a revisão bibliográfica, após um breve resumo da evolução das redes neurais do ponto de vista histórico, o trabalho apresenta as arquiteturas mais relevantes encontradas na literatura. O objetivo é introduzir o tema, inicialmente de maneira ampla, lançando as bases para as seções seguintes, que exploram o estado da arte das aplicações dessas arquiteturas à 3 áreas de interesse: Música, discurso e imagens. Enquanto o interesse nas duas primeiras áreas é mais evidente, uma investigação dos desenvolvimentos em visão de computadores oferece insights importantes; além de ser uma das áreas do aprendizado de máquinas mais ativamente pesquisadas, alguns esforços de transposição dos desenvolvimentos nessa área para o campo da modelagem acústica tem alcançado resultados interessantes.

A seguir, algumas plataformas disponíveis são discutidas e comparadas; novamente, por limitações de tempo, ênfase foi dada aos com maior penetração tanto na indústria quanto na academia, e a escolha da plataforma utilizada nesse trabalho obedeceu mais à critérios de documentação, adoção na comunidade e flexibilidade, do que critérios relacionados diretamente à performance.

A seção seguinte investiga a modelagem acústica convencional, com ênfase no estado da arte da síntese sonora em tempo real. Por tratar-se de uma área mais hermética, sobretudo quando comparada ao campo de redes neurais e sua filosofia código aberto, alguns temas relevantes são apresentados com uma maior profundidade conceitual. Por esse mesmo motivo, implementações didáticas dos dois algoritmos mais utilizados são apresentadas.

Em seguida é apresentado um referencial teórico, onde são formalizadas algumas das bases conceituais do trabalho, como a equação da onda e o funcionamento, do ponto de vista matemático, de uma rede neural; ademais, uma interpretação geométrica para a simetria da transformada discreta de Fourier, quando aplicada a sinais no domínio dos números reais, é introduzida.

A seguir, no capítulo dedicado à metodologia, são apresentadas as etapas executadas, desde o processo de obtenção das amostras de som utilizadas na etapa de treinamento das redes, passando pelas investigações no domínio do tempo e da frequência, até a apresentação em mais detalhes do modelo final proposto, que tem seus resultados comentados na seção seguinte. Na conclusão algumas limitações e possibilidades de encaminhamentos futuros são apresentados.

Os computadores introduziram a produção musical em uma nova era, permitindo, por um lado, experimentações com novos timbres e formas de interação homem máquina para a criação musical e, por outro, a emulação de instrumentos tradicionais, através de técnicas promissoras, como a modelagem acústica (Bovermann et al., 2016).

Avançar essas pesquisas significa, na medida em que, por exemplo, diminui custos de software e hardware dedicados, oferecer a um maior número de pessoas acesso à educação musical e, por conseguinte, uma formação intelectual mais rica.

Algumas vantagens do acesso precoce à educação musical são delineadas no estudo de Forgeard et al. (2008), que sugere uma maior habilidade verbal e uma maior capacidade de raciocínio não verbal em crianças que praticaram instrumentos em sua infância. Na mesma linha, o trabalho de Vaughn (2000) aponta para uma relação entre o estudo voluntário de música e uma melhoria do desempenho matemático, a partir de uma meta análise de 20 estudos.

Uma outra motivação é estimular a descentralização do capital intelectual relacionado ao campo de instrumentos virtuais, desde a década de 70 fortemente concentrado em algumas empresas japonesas, situadas em sua maioria na cidade de Hamamatsu, como Yamaha e Roland (Reiffenstein, 2006). Essas empresas detém, exclusivamente ou parcialmente, as patentes para alguns dos mais importantes algoritmos de síntese sonora, como os digital waveguides.

Após uma breve exposição sobre o nascimento e evolução das redes neurais, com o objetivo principal de conferir familiaridade à área onde o trabalho é desenvolvido, a revisão bibliográfica aqui apresentada assume um caráter pragmático, investigando na literatura, em especial no que tange as pesquisas relacionadas à área de redes neurais, técnicas pertinentes ao desenvolvimento do modelo proposto.

As última seção elenca de maneira bastante concisa o conteúdo relacionado à modelagem acústica “tradicional”, limitando-se aos modelos fisicamente informados mais importantes para o trabalho em tela. A área de síntese digital, que tem aproximadamente a mesma idade da área de redes neurais é, talvez, mais extensa e errática do que esta em sua evolução, e o leitor interessado em uma revisão histórica mais abrangente é referido ao trabalho de Bilbao (2009), que delineia o desenvolvimento do campo desde sua origem em algoritmos abstratos.

Multidisciplinar desde o nascimento, o desenvolvimento das redes neurais artificiais pode ser remontado aos primeiros esforços para sistematização teórica da forma como o cérebro humano funciona, a partir dos trabalhos de Hermann von Helmholtz, Ernst Mach e Ivan Pavlov, na virada do século 19 (Hagan et al., 1996).

Em 1943, o neurofisiologista Warren McCulloch e o matemático Walter Pitts foram responsáveis por formular o primeiro modelo matemático conhecido do cérebro humano (McCulloch e Pitts, 1943), mostrando que topologias simples podem, em princípio, encarregar-se de operações aritméticas e lógicas (Yadav, Yadav e Kumar, 2015) complexas. O trabalho desses autores é considerado o início da pesquisa na área de redes neurais artificiais (Russell e Norvig, 2016).

O termo Inteligência Artificial foi cunhado em 1956 por John McCarthy em uma conferência no Dartmouth College (Coppin, 2004), da qual participaram muitos dos primeiros pesquisadores influentes na área (Brunette, Flemmer e Flemmer, 2009).

Esse termo, assim como o próprio termo inteligência, não se presta a uma definição fácil; para o propósito deste trabalho, no entanto, pode ser entendido como um termo guarda-chuva sob o qual algoritmos que buscam emular aspectos da inteligência humana estão abrigados.

O termo aprendizado de máquinas, por sua vez, é utilizado para denominar um subgrupo da área de inteligência artificial, do qual fazem parte as redes neurais, que ocupa-se de técnicas que permitam que máquinas resolvam problemas sem que sejam explicitamente programadas para tal (Raschka, 2015).

Na área mais ampla denominada de inteligência artificial, redes neurais artificiais possuem um papel primordial pois tem sido, em suas diversas encarnações e arquiteturas, o principal representante do aprendizado de máquinas em diversas aplicações comerciais (Goodfellow et al., 2016).

O primeiro passo para a utilização prática das redes neurais foi dado no final da década de 1950 por Frank Rosenblatt (Hagan et al., 1996), em sua proposta ao laboratório aeronáutico de Cornell de um autômato baseado em seu modelo simplificado de neurônio, o Perceptron (Rosenblatt, 1957).

Tomando como base também as teorias de McCulloch, Widrow desenvolveu a ADALINE (Adaptive Linear Neuron) (Widrow e Hoff, 1960) bastante similar em estrutura ao modelo de Rosenblatt, e partilhando de suas limitações. O modelo de treinamento proposto, no entanto, era consideravelmente mais robusto.

A motivação final de Rosenblatt, inspirada nas teorias sobre o funcionamento do cérebro humano apresentadas por autores como Culbertson, Von Neumann e Ashby (Rosenblatt, 1958) era a construção de uma máquina capaz de aprender à responder diretamente à estímulos físicos externos, como sinais luminosos.

Para tanto, tal máquina utilizaria como unidade fundamental o Perceptron, que funciona matematicamente como uma função aplicada à soma ponderada das entradas e dos vieses dando origem a um classificador linear, capaz de atualizar seus pesos para aprender, através de exemplos de entradas e as correspondentes saídas desejáveis (alvos), a separar linearmente classes diferentes.

A despeito das limitações práticas do modelo proposto, como expostas de maneira um tanto pessimista por Minsky (Minski e Papert, 1969), é interessante notar que muitas das características contemporâneas já estavam presentes nos trabalho seminais de Rosenblatt e Widrow, notadamente o caráter estocástico das redes neurais, a necessidade de treiná-las com base em grandes conjuntos de dados e a característica de caixa preta do modelo treinado.

É interessante observar que Widrow introduziu, como forma de treinamento, uma caso restrito do algoritmo de descida em gradiente, que veio a ser amplamente responsável pelo ressurgimento do interesse em redes neurais décadas mais tarde, em conjunto com uma técnica mais eficiente de atualização dos pesos e vieses de uma rede.

O modelo de Rosenblat, tendo tido sua primeira implementação na forma de uma simulação em um computador IBM 704 (Bishop, 2006), ao contrário da intenção inicial de utilizar hardware específico, inaugura também a prática da simulação neural.

Enquanto uma arquitetura baseada em uma única camada de Perceptrons apresenta severas limitações, o agrupamento sucessivo dessas camadas dá origem a uma topologia, conhecida como Multilayer Perceptron, capaz de atuar como um aproximador universal (Hornik, 1991). Desde que utilize uma função de ativação não-linear (Leshno et al., 1993), e dado um número suficiente de neuronios na camada oculta, essa topologia é capaz de mapear qualquer conjunto de números finitos a qualquer outro com precisão arbitrária (Hornik, Stinchcombe e White, 1989).

Um outro impedimento práticos do trabalhos de Rosenblatt e Widrow foi a ausência de uma metodologia eficiente para a atualização dos pesos da rede, sobretudo envolvendo múltiplas camadas de neurônios - caso não coberto pelos algoritmos iniciais tanto de Rosenblat quanto de Widrow; tal metodologia veio a ser proposta originalmente por Werbos em 1974 (Werbos, 1974). Contudo, essa técnica permaneceu pouco conhecida na comunidade até ser redescoberta por Parker (Parker, 1985) e, pouco tempo depois, Rumelhart (Rumelhart, Hinton e Williams, 1985) na segunda metade da década de 1980 (Mizutani, Dreyfus e Nishio, 2000; Widrow e Lehr, 1990).

O algoritmo, que é conhecido como backpropagation, foi um dos responsáveis por reaquecer o interesse no campo (Hagan et al., 1996) na época, inaugurando sua fase atual, com o surgimento dos principais congressos sobre o assunto, como o IEEE International Conference on Neural Networks e periódicos, a exemplo do INNS Neural Networks, ao fim da década de 1980 (Yadav, Yadav e Kumar, 2015).

Nos anos seguintes, observou-se uma profusão de novas arquiteturas, que foram aprofundando-se na media em que a utilização de um maior número de camadas ocultas foi possibilitada pelos avanços no hardware computacional. Outras formas de organizar camadas sucessivas foram também introduzidas, além de vários avanços incrementais nos algoritmos de treinamento.

Esta seção apresenta as principais arquiteturas consolidadas na literatura, dando ênfase às arquiteturas relevantes ao trabalho aqui desenvolvido. Para uma apresentação mais abrangente, ainda que não exaustiva, o leitor é referido à página preparada pelo The Asimov Institute (Veen, 2018)(http://www.asimovinstitute.org/neural-network-zoo/), onde uma gama maior de arquiteturas é elencada, junto com referência aos artigos onde foram introduzidas.

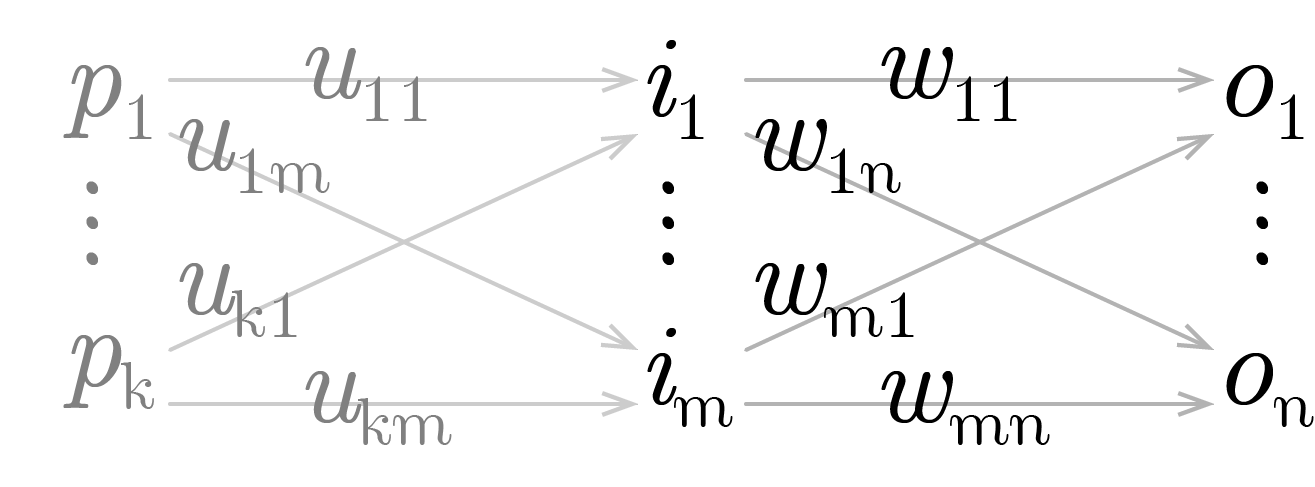

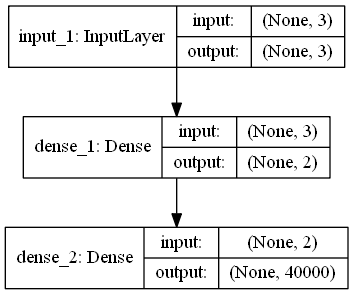

A arquitetura básica no campo das redes neurais artificiais é a chamada densa (Feed-Forward), que consiste de várias camadas sucessivas totalmente ligadas entre si por meio de pesos. Os impulsos recebidos pelas camadas mais baixas fluem sucessivamente para as camadas posteriores, como sugere a nomenclatura em inglês desta arquitetura. São uma generalização do Multilayer Perceptron na medida em que utilizam em geral uma gama mais vasta de funções de ativação, muitas delas de forma sigmoidal, como a função logística \(y = \frac{1}{1 + e ^ {-x}}\) e a tangente hiperbólica \(\tanh(x) = \frac{e^x − e^{-x}}{e^x + e^{-x}}\) (Goldberg, 2016)

Com a melhoria do hardware, a topologia densa foi recebendo um acréscimo de camadas, gerando as redes profundas (Deep Neural Networks). O aspecto mais importante dessa movimentação foi que as redes ganharam a habilidade de gerar representações sucessivas, abstraindo diferentes aspectos dos dados em cada uma de suas camadas.

A grande vantagem desta topologia foi sua capacidade automática de extração dos componentes descritivos dos dados, um trabalho que ficava a cargo dos pesquisadores anteriormente (Socher, 2014). Em contrapartida, a forma como os dados são interpretados pela rede pode não ser facilmente inferida pelo pesquisador, e as redes podem assumir uma forte característica de caixa-preta.

Fonte: Elaboração própria

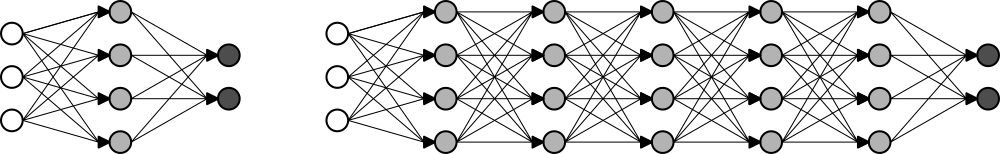

A figura 1 observa-se uma representação esquemática de duas arquiteturas densas: uma rede “rasa”, à esquerda, e uma arquitetura profunda, à direita. Os círculos brancos representam as entradas da rede, enquanto os pretos representam suas saídas. Em cinza, temos a representação dos neurônios que compõe as camadas ocultas da rede.

As redes recorrentes são representações compactas, do ponto de vista técnico, das arquiteturas profundas (Schmidhuber, 2015), devido ao seu caráter recursivo. Conceitualmente, contudo, a abordagem é distinta: Nestas redes os neurons são parcialmente alimentados com seus próprios estados anteriores, emulando um efeito similar à utilização de ligações entre neurons de uma camada anterior com neurons de uma camada posterior não adjacente (Veit, Wilber e Belongie, 2016).

Essa arquitetura foi proposta por Elman (Elman, 1990) com o propósito de capturar informações codificadas no encadeamento temporal de séries de dados, e é bastante poderosa em várias aplicações, como modelos de previsão e classificação de informações (Xu, Auli e Clark, 2015), por exemplo.

Fonte: Elaboração própria

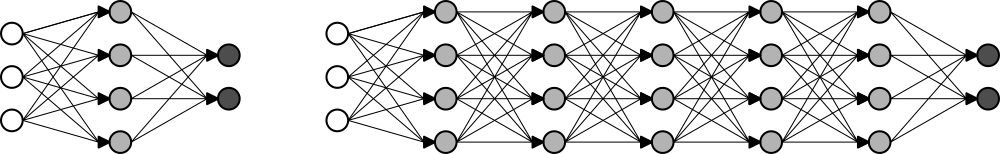

A figura 2 representa 6 passos iniciais de uma rede recorrente. Observa-se que em cada passo, a partir do primeiro, a rede recebe, além do vetor de entrada externo, as próprias saídas que gerou no passo anterior. É oportuno notar que, em algumas aplicações, a rede recebe apenas um vetor de entradas, no primeiro passo, e opera em todos os passos seguintes processando suas entradas anteriores, em uma configuração que recebe o nome de um para muitos (one-to-many) na literatura.

Trata-se de um tipo de arquitetura, geralmente profunda, que é amplamente utilizado em problemas relacionados a imagens, atingindo resultados de ponta em várias áreas relacionadas à visão de computadores, como reconhecimento de objetos e rostos em imagens (Pang et al., 2017).

o problema da alta dimensionalidade dos vetores de entrada, como é o caso da representação de uma imagem por exemplo, é amenizado através da substituição de camadas totalmente conectadas por camadas convolucionais, que varrem a imagem, movimentando-se em cada uma de suas dimensões um passo por vez cada vez (LeCun et al., 1998), e atualizando todos os pesos da camada convolucional de acordo.

Esse procedimento permite a geração, nessas camadas convolucionais da rede, de uma só representação para padrões que aparecem em diferentes pontos do vetor de entrada; tais representações são geralmente interpretadas em camadas posteriores, totalmente conectadas, de forma a gerar o resultado final.

Fonte: Elaboração própria

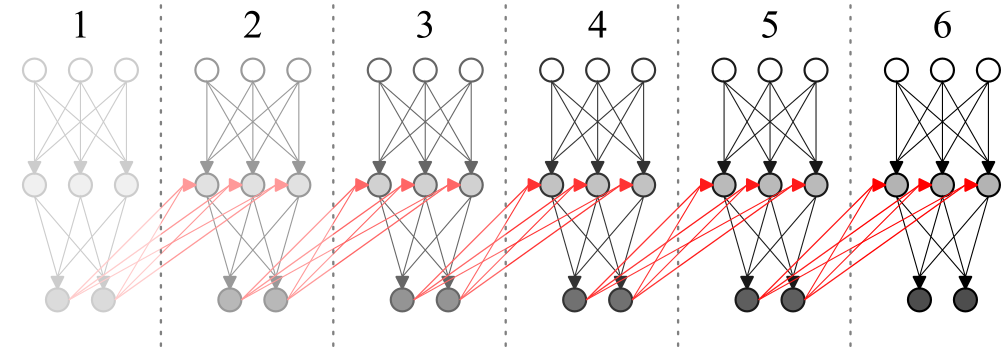

Na figura 3 é possível acompanhar as 3 primeiras entradas de uma rede convolucional unidimensional: o vetor de entrada é “varrido” pela rede, geralmente andando um passo à cada leitura, em um processo análogo à definição matemática de convolução. O trabalho de Dumoulin e Visin (2016) apresenta uma exposição de vários tipos de convolução, dentre as quais a convolução básica em duas dimensões, apresentada na figura 4

Fonte: Dumoulin e Visin (2016)

A maioria dos trabalhos que investigam a aplicação de redes neurais à música, sobretudo envolvendo sua síntese, ocorrem em um nível de abstração mais alto do que a geração direta dos sons: Geralmente tomam como base a manipulação de representações musicais como partituras, por exemplo, ou representações sonoras compactas, como espectrogramas. Os motivos passam pela alta dimensionalidade dos outputs: no caso de um framerate de 44100 samples por segundo, a qualidade encontrada em cds, por exemplo, a síntese de 10 segundos de áudio envolve a criação de mais de 4 milhões de samples.

O trabalho desenvolvido em conjunto pelas equipes do Google Brain team e do DeepMind é um exemplo de esforço nesse sentido (Engel et al., 2017). Nele, uma arquitetura desenvolvida a partir da Wavenet (aprofundada no tópico sobre discurso falado) é utilizada para a geração de ondas sonoras a partir do treinamento direto com amostras de áudio de vários instrumentos musicais. Os resultados mostram que a arquitetura baseada em várias camadas convolucionais utilizada é capaz de aprender representações no domínio do tempo para vários tipos de instrumentos diferentes.

Uma extensão experimental desse trabalho, denominada de Magenta (“Magenta”, [s.d.]), investiga representações latentes para sequências musicais no domínio do tempo, a partir de uma abordagem probabilística (Roberts, Engel e Oore et al., 2018; Roberts, Engel e Raffel et al., 2018).

Uma plataforma física para a manipulação e reprodução dos sons gerados pela rede, na forma de um hardware código aberto denominado Nsynth Super (Eck, 2018; “NSynthSuper”, [s.d.]) é introduzida pela equipe do projeto. Embora não fique claro se a etapa de síntese ocorre diretamente na plataforma, os esforços corroboram o interesse aplicação de redes neurais para a síntese sonora em tempo real.

Enquanto as camadas das arquiteturas anteriores são predominantemente convolucionais, Pfalz (2018) apresenta um trabalho bastante abrangente sobre o uso de redes neurais recorrentes puras para essa finalidade. Um dos primeiros trabalhos na área é, talvez, o desenvolvido por Stanley (2007), consistindo na investigação da capacidade de uma rede em prever sons, em analogia direta com séries temporais. Os resultados são bastante tímidos, e uma rede capaz de prever apenas uma onda sonora, oriunda de uma nota de saxofone, é apresentada. De maneira semelhante, Sarroff e Casey (2014) investiga a aplicação direta de redes neurais, de arquitetura densa, na geração direta de múltiplas amostras de áudio

A geração de música em níveis mais altos de abstração é, para o trabalho aqui desenvolvido, apenas marginalmente interessante, na medida em que pode oferecer inspiração sobre representações compactas dos sons. O trabalho de (Hutchings, 2017), por exemplo, utiliza tablaturas para a previsão de partes completas de bateria tomando como base o ritmo de uma de suas peças.

Tomando emprestados os desenvolvimentos obtidos na área da visão de computadores, os trabalhos de Grinstein et al. (2017) e Mital (2017) buscam transpor os avanços alcançados no campo da transferência de estilo entre imagens para o domínio do som. O primeiro, de cunho exploratório, investiga as arquiteturas mais promissoras para a tarefa, chamando a atenção para o desempenho de arquiteturas rasas, enquanto o segundo investiga, a partir da Wavenet, representações apropriadas. Ainda inspirado em técnicas relacionadas à geração de imagens, Donahue, McAuley e Puckette (2018) faz uso de GANs para a síntese direta de áudio, no contexto da emulação do discurso falado, gerando resultados inteligíveis.

Os esforços de classificação costumam introduzir inovações interessantes nas representações utilizadas:(Costa, Oliveira e Silla, 2017) e (Choi, Fazekas e Sandler, 2016) abordam a tarefa a partir de redes convolucionais; no primeiro trabalho as redes são alimentadas com música representada por um tipo especial de espectrograma enquanto no segundo arquiteturas convolucionais profundas são investigadas, assim como em (Choi et al., 2017) que acrescenta recorrência às arquiteturas convolucionais, no intuito de explorar as inter-relações temporais das amostras sonoras utilizadas.

Representações não canônicas também possuem importante papel nas tarefas relacionadas à transcrição musical a partir do uso de redes neurais, onde busca-se traduzir amostras sonoras em representações de nível mais alto, simbólicas, como tablaturas e partituras, por exemplo. Uma das primeiras contribuições nesse sentido pode ser vista em (Tuohy, Potter e Center, 2006) por meio de um modelo que combina redes neurais e uma heurística hill-climber.

Com o uso de uma rede recorrente, (Boulanger-Lewandowski, Bengio e Vincent, 2013) transcreve, a partir de espectrogramas, diferentes partes musicais em comandos MIDI. Na mesma linha (Böck e Schedl, 2012) e (Sigtia, Benetos e Dixon, 2016) introduzem trabalhos focados na transcrição de sons polifônicos produzidos por pianos. Em relação á transcrição de partes de um kit de bateria, (Southall, Stables e Hockman, 2016) aborda a tarefa a partir de uma arquitetura recorrente alimentada com representações espectrais.

Um dos trabalho mais notáveis nesse sentido, desenvolvido pela equipe de inteligência artificial do Google, é a chamada Wavenet (Van Den Oord et al., 2016; “WaveNet: A Generative Model for Raw Audio”, [s.d.]), uma arquitetura baseada em camadas convolucionais, para a geração ponta a ponta de voz. Um sample é gerado por vez, levando em conta um grande número de entradas passadas; os resultados introduzem um novo estado da arte para a tarefa. Os desdobramentos dessa arquitetura na área musical foram apresentados na seção anterior.

(Hinton et al., 2012) apresenta uma revisão da literatura sobre o uso de modelagem acústica em abordagens baseadas em redes neurais na área de reconhecimento de voz. No mesmo ano (Graves, Mohamed e Hinton, 2013) alcança resultados no TIMIT phoneme recognition benchmark, com a aplicação de redes recorrentes profundas, que estabelecem o novo estado da arte, enquanto (Maas, Hannun e Ng, 2013) aponta a superioridade da função de ativação relu (rectifier nonlinearities) sobre ativações de caráter sigmoidal em tarefas relacionadas ao reconhecimento contínuo da fala.

A partir de uma arquitetura hibrida, combinando um modelo fonético recorrente com um classificador acústico baseado em uma rede neural profunda, (Boulanger-Lewandowski et al., 2014) aplica estratégias de sequenciamento telefônico para estabelecer um novo benchmark no TIMIT dataset, uma técnica que foi comprovada por (Sak et al., 2015) como superior ao uso de arquiteturas como deep long short-Term memory recurrent neural networks e as abordagens mais utilizadas à época baseadas no modelo oculto de Markov.

Com relação à utilização de redes convolucionais, Sainath et al. (2015) investiga a otimização de seus hiperparametros, além de estratégias de pooling e treinamento para aplicações em reconhecimento de fala, enquanto Zweig et al. (2017) e Zhang et al. (2017) exploram o desempenho de sistemas baseados somente em redes neurais (end-to-end), com o último combinando redes convolucionais hierárquicas com classificação temporal coneccionista. Nessa mesma linha, o trabalho de (Zhang, Chan e Jaitly, 2017)também investiga sistemas end-to-end a partir de uma arquitetura combinando redes neurais convolucionais profundas com recorrência e princípios baseados no aninhamento de redes neurais (NIN, network in a network). Alguns desses princípios, notadamente a justaposição de convolução e recorrência, inspiraram a implementação apresentada na seção sobre convolução e recorrência.

Recentemente tem-se visto esforços para adaptar métodos utilizados com sucesso na área da visão de computadores ao campo da modelagem acústica. O trabalho de (Engel et al., 2017), batizado de Nsynth, busca inspiração na área de geração de imagens para elaborar uma arquitetura apropriada a síntese sonora. Ainda em paralelo com a área de relacionada à imagens, o autor propõe um base de dados sonora à luz de bases de dados clássicas no campo de visão de computadores, como o MNIST, em um esforço para alavancar pesquisas nessa direção.

Da mesma forma a Wavenet, antecessora do Nsynth, é uma adaptação das arquiteturas PixelRNN (Oord, Kalchbrenner e Kavukcuoglu, 2016) e PixelCNN(Oord et al., 2016), desenvolvidas para a geração de imagens.

Os trabalhos que tem como foco a síntese de imagens geralmente envolvem as chamadas GANs: trata-se de uma abordagem onde uma rede é treinada para gerar imagens, enquanto outra as classifica em artificiais ou não. O objetivo da primeira rede é enganar a segunda, dando origem a imagens mais realistas, do ponto de vista da percepção humana.

Isola et al. (2016), por exemplo, utiliza essa técnica para gerar imagens a partir de representações de seus contornos, enquanto Hwang e Zhou (2016), Zhang, Isola e Efros (2016), Larsson, Maire e Shakhnarovich (2016) e Iizuka, Simo-Serra e Ishikawa (2016) abordam a tarefa de colorização automática de imagens.

Ainda usando redes adversariais (Frans, 2017) introduz controle ao processo de colorização, com a utilização de mapas de cores, que são usados como entradas para as redes, um conceito que é explorado também por Sangkloy et al. (2016), onde a interação do usuário e uma rede densa permitem a colorização de imagens em tempo real, através de linhas desenhadas em áreas da imagem que possuam as cores pretendidas.

Gatys, Ecker e Bethge (2016) propõe uma técnica de transferência de estilo, utilizando uma rede convolucional capaz de aprender características do estilo de uma imagem e transferir para outra, sem alterar o seu conteúdo semântico. Nessa linha,[Kulkarni et al. (2015) utiliza uma arquitetura de convolução-desconvolução para separar características de posicionamento de uma imagem, permitindo sua reconstrução posterior em outras posições e situações de iluminação, a partir de mudanças manuais nas variáveis de entrada da rede. Ainda investigando a manipulação de imagens a partir de redes adversariais o trabalho de Zhu et al. (2016) tem como objetivo aprender características das imagens de maneira direta.

O trabalho de Oord, Kalchbrenner e Kavukcuoglu (2016), que veio a inspirar a Wavenet, propõe um topologia recorrente profunda com conexões residuais melhoradas capaz de reconstruir imagens parcialmente obstruídas, enquanto (Theis e Bethge, 2015) investiga arquiteturas LSTM multi dimensionais no contexto da modelagem da distribuição de imagens.

Na área de vídeo, que pode ser entendida como um caso geral da manipulação de imagens, com complexidades adicionais relacionadas à alta dimensionalidade dos dados e ao encadeamento temporal Karpathy et al. (2014) investiga abordagens capazes de estender as redes convolucionais de forma a permitir que tirem proveito das características temporais dos dados de entrada. De forma semelhante, portando desenvolvimentos na área de reconhecimento de expressões faciais obtidos em imagens, Khorrami et al. (2016) combina redes recorrentes e convolucionais, medindo a importância relativa de cada uma nos resultados finais.

Buscando combater a alta dimensionalidade, Yang, Krompass e Tresp (2017) apresenta o conceito de tensor-train, permitindo a transferência de conhecimento de outras arquiteturas para a utilização em dados sequenciais com alta dimensionalidade. O trabalho de He et al. (2015) introduz novos benchmarks à tarefa de reconhecimento de emoções em vídeos, utilizando uma arquitetura profunda baseada em camadas LSTM bidirecionais no processamento de vídeos, incluindo seu áudio.

A área de aprendizado de máquinas encontra-se muito ativa atualmente, tanto no âmbito da academia quanto no da indústria, com várias grandes empresas de tecnologia incorporando essa tecnologia em suas competências essenciais. Dessa forma, assistimos à uma proliferação de ferramentas e plataformas focadas em diferentes aspectos da área, muitas delas desenvolvidos ou endossados por essas empresas, como Microsoft, Google e Amazon. Somando-se a isso o fato de que, em maior ou menor grau, todos eles apresentam uma curva de aprendizado significativa, fica evidente que uma comparação direta de todos, ou mesmo da maioria das ferramentas disponíveis, encontra-se além do escopo deste trabalho.

Algum direcionamento, contudo, pode ser obtido a partir da literatura disponível. Bahrampour et al. (2016), por exemplo, compara quatro ferramentas: Caffe (“Caffe”, [s.d.]), desenvolvida pelo grupo de pesquisas em inteligência artificial de Berkeley (“Berkeley Artificial Intelligence Research Lab”, [s.d.]); Neon (“Neon”, [s.d.]), desenvolvido pelo setor de inteligência artificial da Intel; Torch (“Scientific computing for LuaJIT.”, [s.d.]) e Theano (“Theano”, [s.d.]) os dois últimos sem afiliações diretas com grandes empresas. O autor conclui pela superioridade da plataforma Theano, em termos de velocidade em geral e flexibilidade, chamando atenção para sua capacidade de auto-diferenciação.

Embora o time principal tenha abandonado o desenvolvimento do Theano no final de 2017 a plataforma Tensorflow (“TensorFlow”, [s.d.]), introduzida por pesquisadores do Google Brain Team em 2015 é, em muitos aspectos, sucessora do Theano, conservando a maioria de suas características.

Se um estudo realizado pelo mesmo autor em 2015 (Bahrampour et al., 2015) indicava alguma ineficiência da plataforma, à época ainda em sua infância, o trabalho de Shi et al. (2016), ao comparar 5 plataformas, conclui que a situação 1 ano depois é diferente, e que não há uma plataforma sensivelmente superior às outras em termos gerais.

O trabalho de Erickson et al. (2017) é ainda mais abrangente, comparando 12 frameworks, e chamando atenção para a importância das habilidades prévias e características da pesquisa na escolha da ferramenta mais apropriada. Na mesma linha, Parvat et al. (2017) compara 5 plataformas, chamando atenção para as potenciais vantagens, em termos do tamanho do código e rapidez na criação de protótipos, da utilização de bibliotecas de nível de abstração mais alto, como a biblioteca Keras (“Keras: The Python Deep Learning library”, [s.d.]), no topo das plataformas convencionais.

Excluídas as técnicas baseadas em manipulação de amostras pré-gravadas de sons, talvez a abordagem mais utilizada por músicos atualmente (Bilbao, 2009), podemos dividir área de síntese sonora propriamente em duas escolas, na medida em que ocupa-se em modelar os processos físicos que dão origem ao som (Modelagem Física - Physical Modelling) ou diretamente as características das ondas sonoras (Modelagem Espectral - Spectral Modelling) (Serra, 2007).

Dessas escolas, a modelagem física é a mais proeminente tanto do ponto de vista da pesquisa quanto de aplicações; a área de modelagem espectral parece ter despertado pouco interesse dos pesquisadores nas últimas duas décadas, encontrando a maioria de suas aplicações recentes em áreas fora da síntese musical. A modelagem física apresenta como principais vantagens um menor número de parâmetros, que costumam ser mais intuitivos, na medida em que são diretamente relacionados à grandezas existentes no mundo real.

Abordagens baseadas na modelagem física ocupam-se majoritariamente em formular modelos discretos baseados em descrições matemáticas dos instrumentos, como por exemplo a solução de D’alembert para a equação da onda (Karjalainen e Erkut, 2004), normalmente incorporando ao modelo termos relacionados por exemplo à rigidez exibida por cordas não ideais, que modelem características relevantes ao timbre do instrumento representado (Bensa et al., 2003). Destacam-se, nessa escola, duas abordagens: o método das diferenças finitas, acurado e computacionalmente intensivo, e os Digital Waveguides, um modelo bastante eficiente (Bensa et al., 2005) e elegante que é, talvez, o mais utilizado para a emulação em tempo real de instrumentos acústicos.

A formulação mais básica desse método consiste na resolução da equação da onda propagando-se em uma corda ideal, introduzida abaixo e derivada com mais detalhes na seção seguinte.

\[\frac{\partial^2 y(x,t)}{\partial t^2} =\frac{T}{\rho} \frac{\partial^2 y(x,t)}{\partial x^2}\](1)

A solução é buscada para pontos em uma malha obtida discretizando-se tanto o tempo \(t\) quanto a posição horizontal \(x\). Isso permite a aproximação das derivadas parciais de segunda ordem pelo método das diferenças centrais. Assim procedendo, podemos reescrever a equação da onda como abaixo.

\[\frac{y[i,j+1]-2y[i,j]+y[i,j-1]}{\Delta t^2} = c^2 \frac{y[i+1,j]-2y[i,j]+y[i-1,j]}{\Delta x^2}\]

onde

\(c=\sqrt{\frac{T}{\rho}}\)

\(x_i = i \Delta x, i \in \{0,1,...,M\}\)

\(t_j = j \Delta t, j \in \{0,1,...,N\}\)

e, colocando \(y[i,j+1]\) em evidência:

\[ y[i,j+1] = 2 y[i, j] - y[i,j-1] + C^2 (y[i+1, j] - 2 y[i, j] + y[i-1, j])\]

Em \(C=c \frac{\Delta t}{\Delta x}\), denominado número de Courant, foram aglutinados todos os parâmetros que governam a qualidade da simulação. Para garantir sua estabilidade, os parâmetros devem ser fixados de modo que \(C\) seja menor que 1.

Repare que $ y[i,j+1]$ é calculado com base no ultimo e penúltimo momentos discretos, o que demanda, para o primeiro passo da simulação em \(j = 1\), a definição do estado inicial do sistema em \(j=0\), e informações sobre o sistema no momento discreto indefinido \(j=-1\). Essa última dificuldade será atacada a partir de considerações adicionais sobre o sistema.

Como condições de contorno para o caso contínuo temos que, no momento inicial, a corda encontra-se deslocada do seu equilíbrio, em repouso. Portanto, a velocidade em \(t=j=0\), para qualquer ponto \(x\) da corda, tem valor zero. Ademais, define-se a corda como fixa em suas extremidades nos pontos \(x=0\) e \(x=L\). Para primeira condição podemos escrever:

\[ \frac{\partial y(x,t)}{\partial t} \approx \frac{y[i,1]-y[i,-1]}{2 \Delta t} = 0 ~ \forall ~ i \in \{0,1,...,M\} \]

o que implica:

\[ y[i,1] = y[i,-1] ~ \forall ~ i \in \{0,1,...,M\} \]

Assim, para o primeiro momento da simulação em \(j=1\) podemos substituir \(y[i,-1]\) por \(y[i,1]\), obtendo a equação para quando \(j=0\):

\[ y[i, 1] = y[i, 0] + \frac{1}{2} C^2 (y[i+1, 0] - 2 y[i, 0] + y[i-1, 0])\]

Em relação à segunda condição, devemos reforças o fato de que \(y[0, j] = y[L, j] = 0 ~ \forall ~ j \in \{0,1,...,N\}\) em cada passo da simulação.

É conveniente colocar a formulação em termos físicos: se considerarmos, por exemplo, um framerate típico de 44100 amostras por segundo podemos evitar desperdício computacional fazendo com que os passos da simulação coincidam com o intervalo de 1/44100 segundo entre os pontos amostrados. De modo geral, levando em conta que \(C \le 1\), podemos parametrizar a simulação em termos dos componentes físicos e o framerate desejado da seguinte forma:

\(dt = \frac{1}{FPS} = \frac{D}{N}\)

\(N = D ~ FPS\)

\(dx = \frac{L}{M}\)

\(M \le \frac{FPS}{2f}\)

\(c = 2fL\)

onde \(D\) é a duração desejada, em segundos; \(L\) é o comprimento da corda em metros e FPS é o framerate pretendido.

O fragmento de implementação no quadro 1, na linguagem Python, faz as vezes de pseudocódigo e ajuda a ilustrar o funcionamento do algoritmo. A versão completa do código, com a possibilidade da geração do gráfico da onda, pode ser encontrada em Tesserato (2018), no caminho “resources/Finite_Difference.py”.

amplitude = 0.005 # meters

pluck_position = .5 # fraction of L

pickup_position = .5 # fraction of L

fps = 44100 # samples / second

frequency = 440 #hz

duration = 1 # seconds

L = 0.6 # meters

sustain = .9998

N = int(duration * fps) # number of time points

dt = 1 / fps # spacing beetwen discrete time points

M = int(fps / (2 * frequency)) # number of position points

dx = L / M # spacing beetwen discrete position points

c = frequency * 2 * L # meters / second

C = c * dt / dx # Courant number

x = np.arange(0, M + 1, 1) * dx

t = np.arange(0, N + 1, 1) * dt

pickup = int(round(M * pickup_position))

asc = int(round(M * pluck_position))

dsc = M + 2 - asc

X_asc = np.linspace(0, 1, asc)

X_dsc = np.linspace(0, 1, dsc)[::-1][1: ]

y = np.zeros(M + 1)

y_1 = np.hstack([X_asc,X_dsc]) * amplitude * np.random.normal(1, .01, M + 1) # initial displacement shape

y_2 = np.zeros(M + 1)

ctr=0

w = []

for i in range(1, M):

y[i] = y_1[i] + 0.5 * C**2 *(y_1[i+1] - 2*y_1[i] + y_1[i-1])

y[0] = 0

y[M] = 0

w.append(y[pickup])

y_2[:] = y_1

y_1[:] = y

ctr += 1

for j in range(1, N):

print('step ', ctr,' of ', N)

for i in range(1, M):

y[i] = 2 * y_1[i] - y_2[i] + C**2 * (y_1[i+1] - 2*y_1[i] + y_1[i-1])

y[0] = y[0] * 0.5

y[M] = y[M] * 0.5

y = y * sustain

w.append(y[pickup])

y_2[:] = y_1

y_1[:] = y

ctr += 1

w = np.array(w) * 4000000Implementação na linguagem Python do Método das Diferenças Finitas

Fonte: Elaboração própria

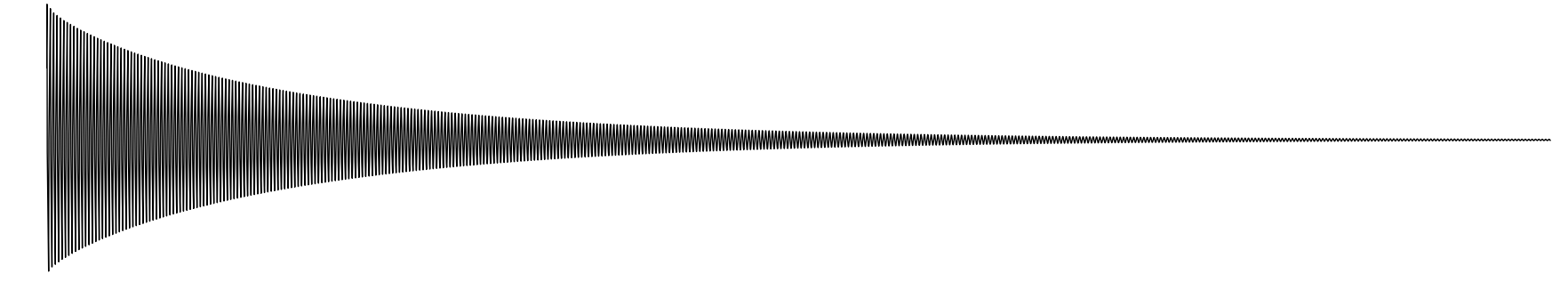

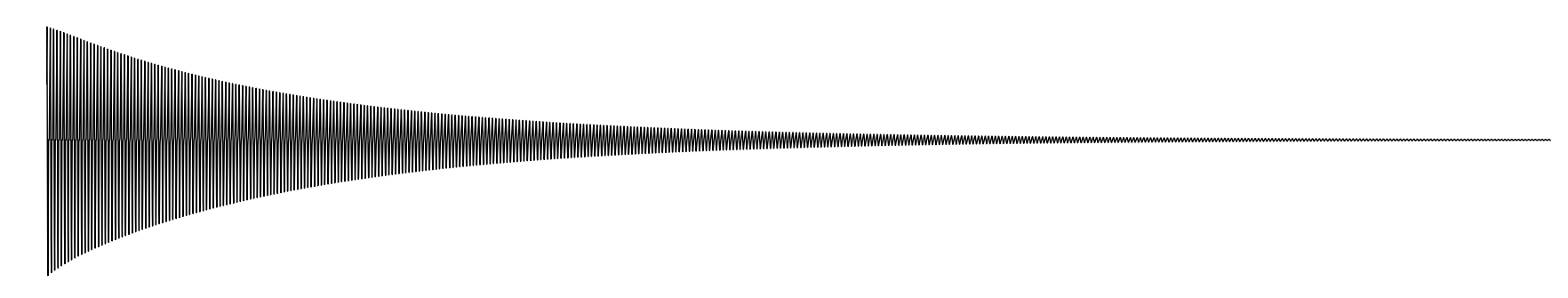

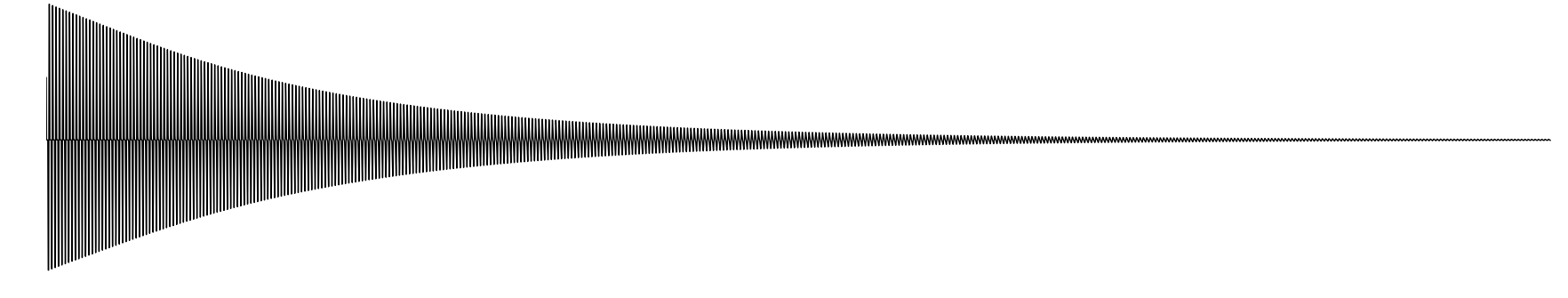

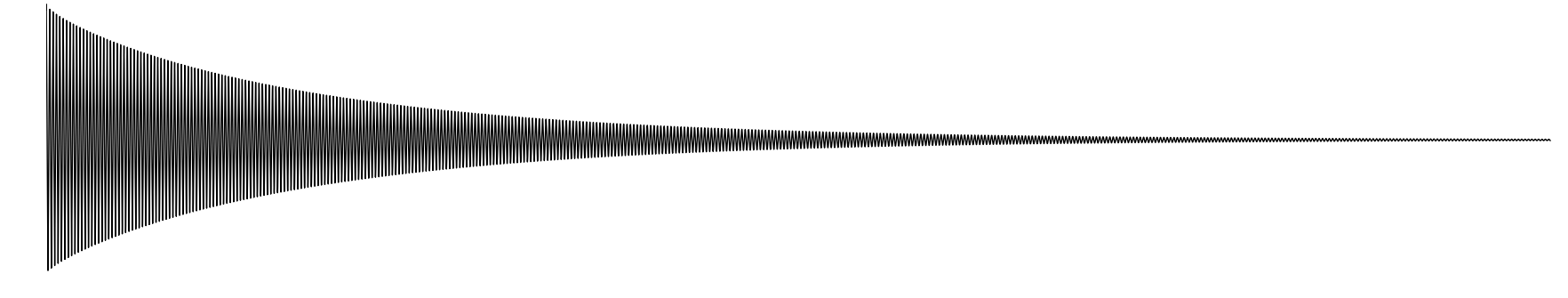

Uma animação relativa a uma onda de frequência real igual a 440 Hz, criada pela implementação acima, pode ser encontrado no repositório da dissertação (Tesserato, 2018), no caminho “resources/Demo Finite Difference/”, junto com áudios de diversas ondas, com locais de excitação e captação variados. É interessante observar o efeito da variação desses parâmetros no timbre da onda sonora gerada. Cabe notar que a velocidade e a escala da animação estão bastante distorcidas, para facilitar a visualização.

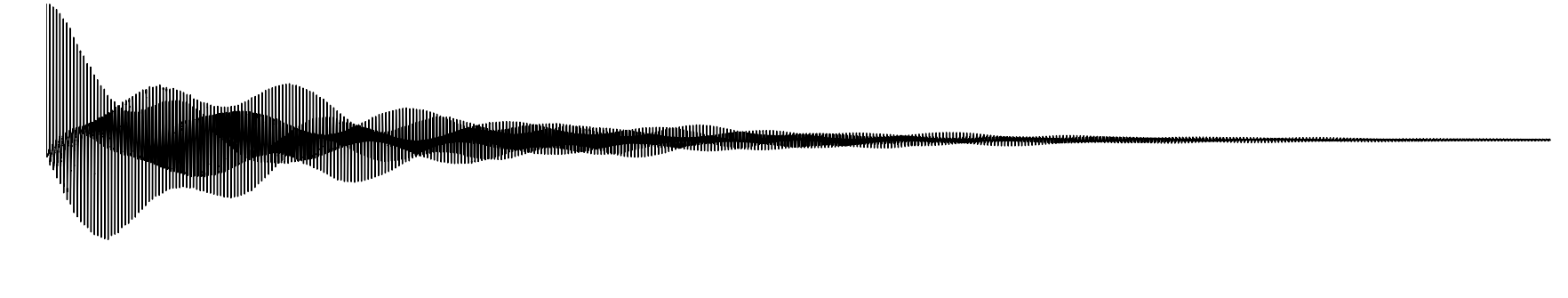

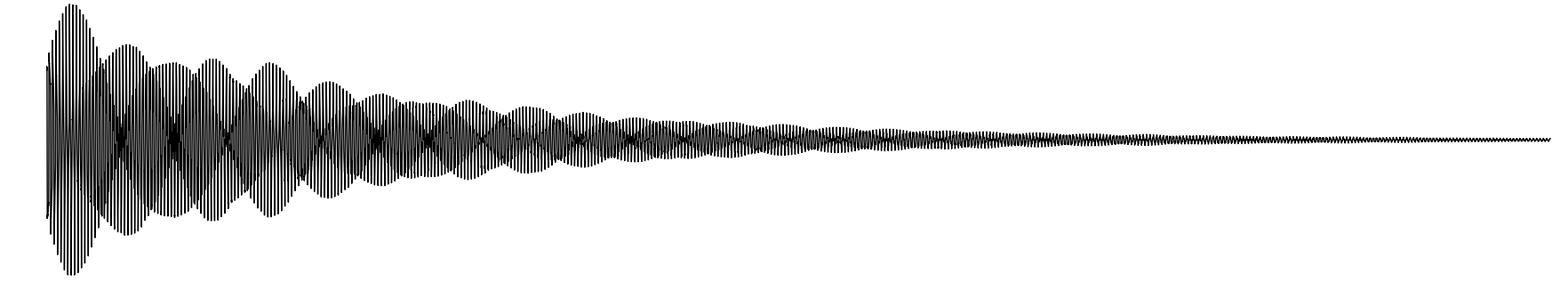

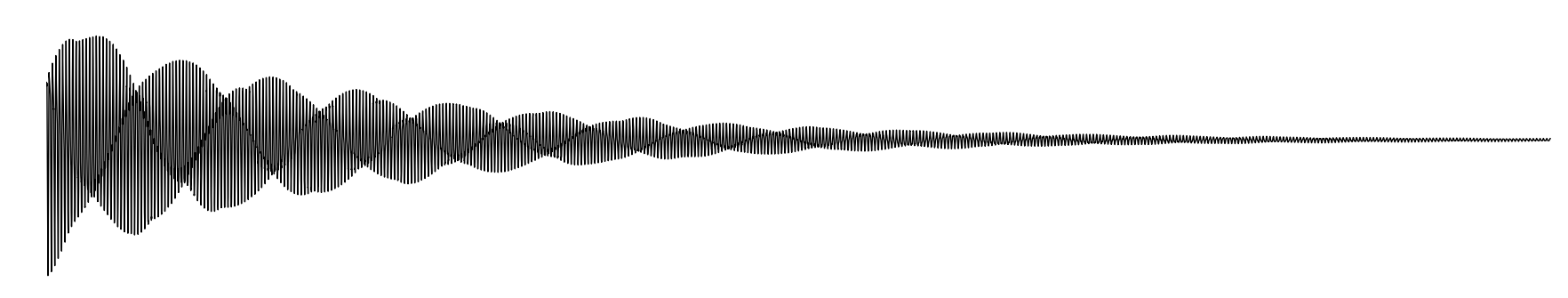

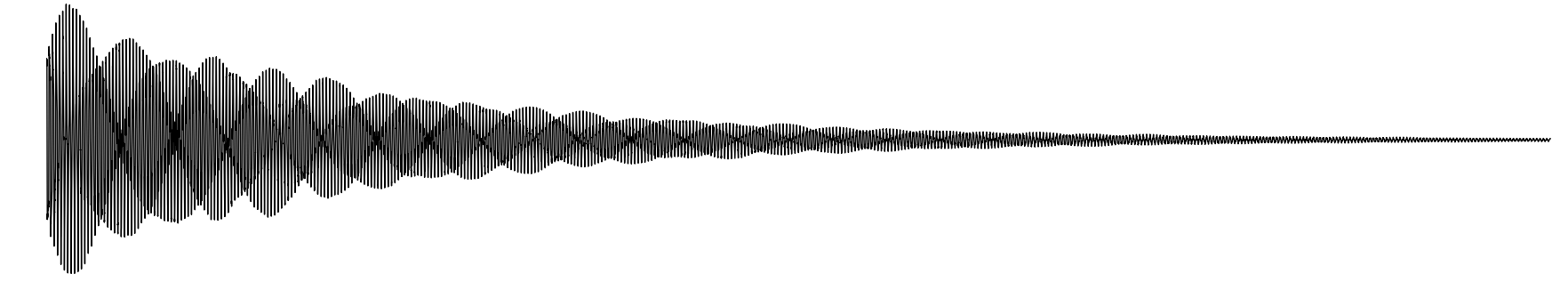

Fonte: Elaboração própria

Fonte: Elaboração própria

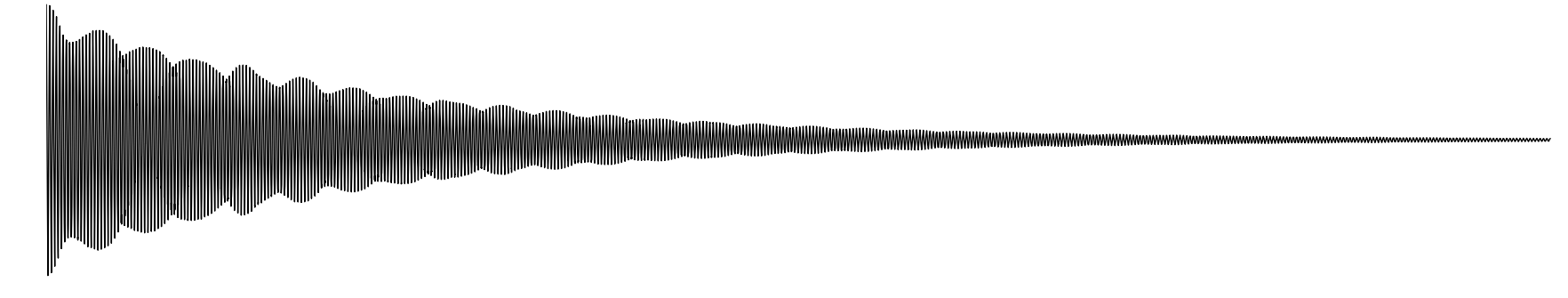

Fonte: Elaboração própria

Fonte: Elaboração própria

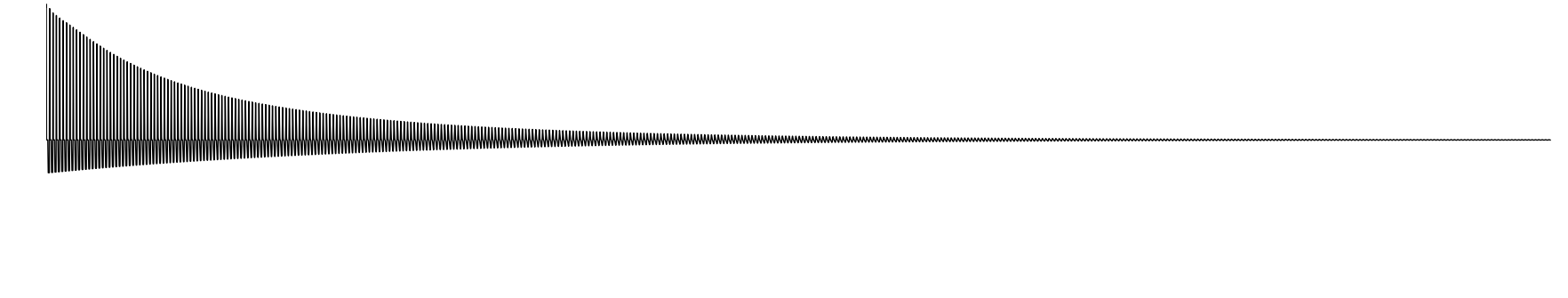

Fonte: Elaboração própria

Esse algoritmo consiste em uma abordagem simplificada da modelagem física, na medida em que concentra em alguns pontos discretos os cálculos necessários à simulação, aumentando bastante a eficiência computacional do modelo (Van Duyne e Smith, 1995).

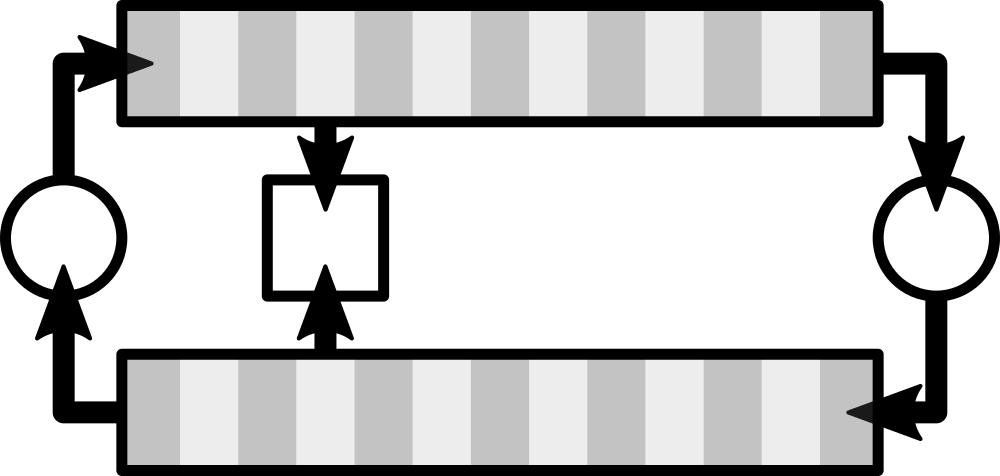

Conceitualmente, podem ser vistos como uma caso especial do método das diferenças finitas (Van Duyne e Smith, 1993), e a maioria de suas implementações consistem na utilização de delay lines e filtros digitais para a modelagem da propagação da onda (Smith, 2006). O modelo também parte da equação da onda equação 1, discretizada da forma apresentada no contexto do método das diferenças finitas. A formulação analítica, no entanto, é abandonada, em favor de uma interpretação mais diretamente baseada na interpretação das duas ondas viajando em sentidos opostos na corda. A imagem abaixo apresenta a intuição do método, que representa ainda hoje o estado da arte da modelagem física (Bilbao, 2009).

Fonte: Elaboração própria

As duas linhas quadriculadas apresentadas na figura 10 são as chamadas delay lines, por onde a onda circula inalterada, em uma direção: no exemplo, na linha superior a perturbação viaja da esquerda para a direita, e da direita para a esquerda na linha de baixo. Essa movimentação geralmente ocorre em uma estrutura de dados denominada circular buffer. O movimento de reflexão da onda quando alcança as extremidades fixas da corda é calculado nos pontos representados por cículos na figura 10, que são responsáveis por enviar os samples de um buffer para o outro, invertendo seu sinal; nesses pontos, geralmente a partir da utilização de filtros digitais, outras manipulações são introduzidas, no sentido de emular perdas e fatores relacionados à rigidez de uma corda não ideal. O quadrado, na figura 10 representa a posição onde a onda é amostrada, a partir da soma do conteúdo das duas delay lines. Esse sistema, como um todo, recebe o nome de digital waveguide.

Do ponto de vista físico os digital waveguides, representam uma corda fixa em suas terminações, por onde um pulso viaja, sendo refletida nas extremidades. Ao passar de uma linha pra outra, a onda é espelhada e invertida e todos os cálculos são concatenados nesses pontos ou, dependendo da simulação, em apenas um desses pontos, como é o caso da implementação apresentada no quadro 2, aumentando consideravelmente a eficiência da simulação.

No modelo mais básico, um termo de perda é calculado durante a transição de uma linha para outra, enquanto implementações mais sofisticadas fazem uso dos filtros para emular além da rigidez das cordas, alguns outros fenomenos mais sofisticados, como dispersão, por exemplo. O modelo pode ser extendido também para emulações bidimensionais (Mullen, 2006) e tridimensionais [Fontana, Rocchesso e Apollonio (2000); Laird (2001); speed2012voice] , e presta-se à implementações bastante eficientes, principalmente em uma dimensão.

No quadro 2, é apresentado um exemplo em Python, à guisa de pseudocódigo. Observa-se que a implementação é mais simples do que a do método das diferenças finitas, e mais eficiente, como a 1 demonstra. Como antes, a versão funcional do código pode ser acessada em Tesserato (2018), no caminho “resources/Digital_waveguide.py”, e uma animação ilustrando uma onda gerada pelo método, além dos com diferentes valores para o ponto de excitação e captação áudios, podem ser acessados no mesmo repositório, em “resources/Demo Digital Waveguide/”

path = 'Demo Digital Waveguide/'

n = 44100

fps = 44100

frequency = 440

amplitude = 20000

pluck_position = .1

pickup_position = .1

sustain = .99

smoothing = 3

plot = True

L = int(round(fps / (2 * frequency)))

pickup = int(round(L * pickup_position))

asc = int(round(L * pluck_position))

dsc = L - asc

X_asc = np.linspace(0, 1, asc)

X_dsc = np.linspace(0, 1, dsc + 1)[::-1][1: ]

delay_r = np.hstack([X_asc,X_dsc])

delay_l = np.zeros(L)

w = np.zeros(n)

zeros = np.zeros(L)

for i in range(n):

print('step ', i + 1,' of ', n)

w[i] = delay_r[pickup] + delay_l[pickup]

to_l = -1 * np.average(delay_r[-smoothing:]) * sustain # to add in delay_l[L-1] AFTER rolling

delay_r = np.roll(delay_r, 1)

delay_r[0] = -1 * delay_l[0]

delay_l = np.roll(delay_l, -1)

delay_l[L-1] = to_lImplementação na linguagem Python do algoritmo Digital Waveguides

Fonte: Elaboração própria

Fonte: Elaboração própria

Fonte: Elaboração própria

Fonte: Elaboração própria

Fonte: Elaboração própria

Fonte: Elaboração própria

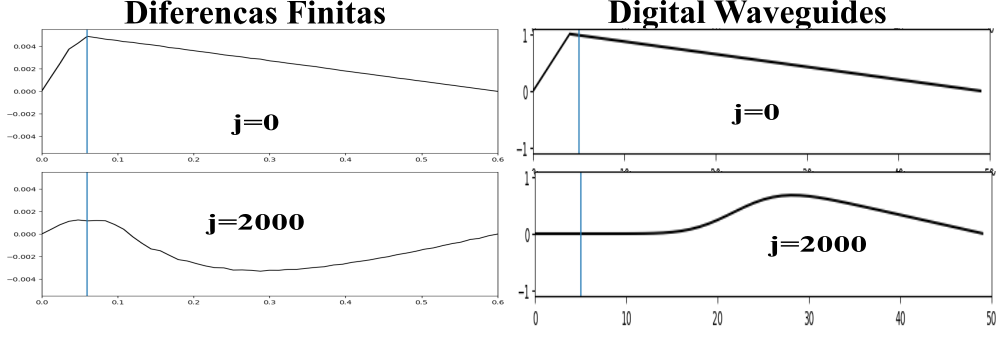

Para a comparação dos dois algoritmos, alguns exemplos de ondas equivalentes, geradas por ambos, foram preparados, a fim de basear um julgamento subjetivo. A figura 16 compara o primeiro frame e último das simulações da evolução do pulso em uma corda para os dois métodos.

Fonte: Elaboração própria

A movimentação da onda produzida a partir do método das diferenças finitas tem um caráter mais organico, enquanto é, também, mais propensa a desvios da condição de estabilidade, enquanto a simulação a partir do algoritmo de digital waveguides é mais robusta, porém mais mecânica Em relação às eficiências, abaixo são elencados os tempos que foram necessários para a geração dos sons apresentados anteriormente. Todas as amostras tem framerate igual a 44100 FPS e duração de 1 segundo. Os tempos são apresentados em segundos.

| Excitação | Captação | Digital Waveguides | Diferenças Finitas |

|---|---|---|---|

| 0.1 | 0.1 | 13.811148881912231 | 16.9521381855011 |

| 0.1 | 0.5 | 13.020658254623413 | 19.620429277420044 |

| 0.3 | 0.7 | 11.332738161087036 | 24.256462335586548 |

| 0.5 | 0.1 | 12.350087404251099 | 17.89053726196289 |

| 0.5 | 0.5 | 12.122233390808105 | 18.002467393875122 |

Fonte: Elaboração própria

O objetivo deste capítulo é oferecer uma definição mais formal das principais ferramentas utilizadas neste trabalho.

A transformada de Fourier, em sua forma contínua, é um tipo de transformada integral, como abaixo:

\[ X(f) = \mathcal{F}\{x(t)\}=\int_{-\infty}^\infty x(t) e^{- 2 \pi f t \ i} dt \](2)

\[ x(t) = \mathcal{F}^{-1}\{X(f)\}=\int_{-\infty}^\infty X(f) e^{2 \pi f t \ i} df \](3)

Tendo sido formulada por Fourier, enquanto investigava o fenômeno da transferência de calor (Stein e Shakarchi, 2003), trata-se de uma das ferramentas mais utilizadas na investigação de sistemas físicos (Lyons, 2011; Olson e Levitt, 2017).

Esta ferramenta parte da premissa de que qualquer sinal contínuo e periódico pode ser representado a partir de uma soma de senoides (Smith e others, 1997) permitindo que a descrição de um sinal \(x(t)\), em relação ao tempo, seja transformada em uma representação deste mesmo sinal em termos das frequências que o compõe, na forma \(X(f)=\mathcal{F}\{x(t)\}\); \(x(t)\) e \(X(f)\) são denominados um par de Fourier.

A versão discreta da transformada de Fourier, apresentada abaixo, é uma das ferramentas mais importantes e utilizadas no campo de processamento de sinais (Gazi, 2018); contribui para essa penetração a descoberta de um algoritmo eficiente , denominado de Fast Fourier Transform, que diminuiu consideravelmente o número de operações necessárias ao cômputo da transformada discreta de Fourier (Pereyra e Ward, 2012).

\[ X[m] =\sum_{n=0}^{N-1} x[n] e^{- 2 \pi m n / N ~ i} \](4)

\[ x[n] = \frac{1}{N}\sum_{m=0}^{N-1} X[m] e^{2 \pi m n / N ~ i} \](5)

onde \(x\) e \(X\) são sequências de \(N\) números complexos. Utilizando a fórmula de Euler, \(e^{x ~ i} = \cos(x) + \sin(x)~i\), podemos alterar a definição acima, da forma exponencial, para a trigonométrica, reorganizando o expoente de forma a evidenciar algumas características importantes, na forma abaixo.

\[ X[m] =\sum_{n=0}^{N-1} x[n] \cos \left(m ~ \frac{2 \pi}{N} ~ n \right)- x[n] \sin\left(m ~ \frac{2 \pi}{N} ~ n \right) ~ i \]

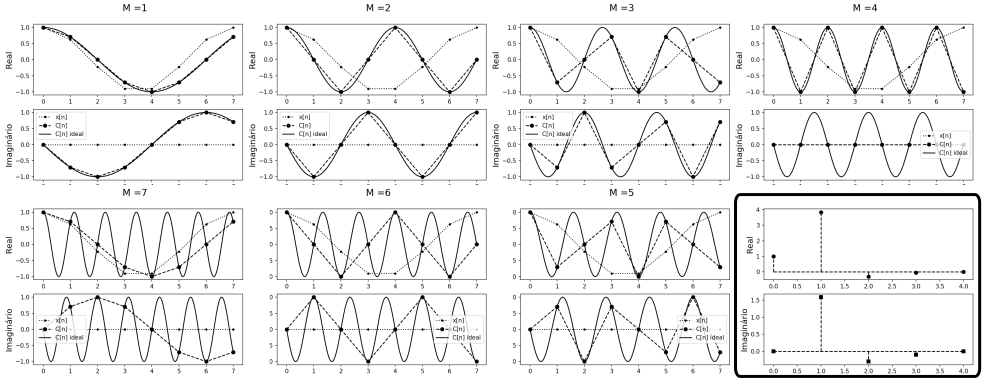

A forma acima torna mais fácil uma interpretação geométrica do algoritmo. Para cada valor de \(m ~ \in ~ {0,1,2,...,N-1}\) é feita a multiplicação, elemento a elemento, das \(N\) posições do impulso \(x\) com \(N\) posições de um onda em forma de cosseno (\(C(m)\)), pura, de “frequência” \(m\), na parte real da equação. Analogamente, em sua parte imaginária, o mesmo processo ocorre: cada posição medida do impulso \(x\) também é multiplicada pela posição equivalente, desta vez, de uma onda em formato de seno(\(S(m)\)), com “frequência” \(m\).

Note-se que esta “frequência”, e por isso a insistência nas aspas, refere-se a quantos ciclos das ondas (\(C(m)\)) e (\(S(m)\)) acima definidas estão contidos no espaço dos \(N\) pontos utilizados na transformada e não corresponde diretamente à frequência física da onda; essa relação é regida por \(f_l = \frac{f_r}{FPS . N}\), onde \(f_l\) é a frequência local, e \(f_r\) sua frequência real, física.

Para o caso de sinais que, no domínio do tempo, consistem de uma sequência finita de números reais, como é o caso dos sinais considerados neste trabalho, pode-se, à luz da definição acima, derivar uma interessante e útil propriedade do algoritmo: A descrição do sinal no domínio da frequência é conjugado-simétrica em torno de sua mediana, de forma que \(X[m] = X^* [N-m]\), com \(X^*\) denotando o conjugado complexo de \(X\). Dessa forma, sendo \(N\) par, precisamos de apenas de \(N/2+1\) termos de \(X[m]\) para descrever completamente o pulso no domínio da frequência, enquanto \((N+1)/2\) são suficientes caso \(N\) seja ímpar. A figura 17 ilustra geometricamente essa propriedade.

Fonte: Elaboração própria

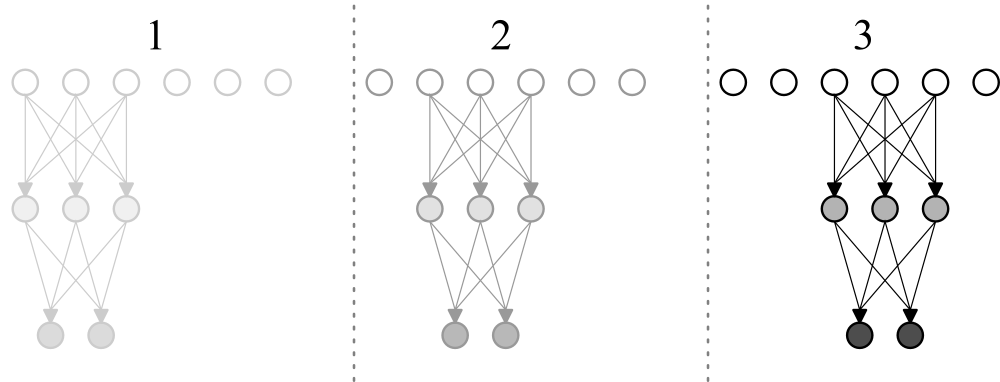

Na figura 17 é a presentado o resultado da transformada discreta de uma onda composta por 8 amostras, que pode ser vista no retangulo inferior da imagem. Os outros retangulos ilustram os respectivos passos e a simetria entre passos equidistantes de \(n/2\). O motivo da simetria, causado pela perda de informação ao tomar apenas alguns pontos, torna-se explícito quando observado do ponto de vista geométrico: os 8 pontos equidistantes tomados como amostra, por exemplo, de uma senoide com frequência igual a 2 coincidem com os retirados de uma senoide com frequência igual a 6, já que partes do ciclo são ignorados.

O código em Python apresentado no quadro 3, utilizado para gerar os quadros da figura 17, serve para elucidar numericamente o exposto. É interessante notar que a interpretação geométrica da simetria da transformada discreta de Fourier aplicada em ondas puramente reais, até onde alcança o conhecimento do autor, é apresentada pela primeira vez neste trabalho. Cabe observar que implementações mais eficientes, como o referido algoritmo FFT, utilizadas na prática, tiram proveito da simetria da transformada, entre outras alterações mais sofisticadas, para economizar operações (Sorensen et al., 1987).

import numpy as np

import matplotlib.pyplot as plt

from scipy.fftpack import fft

# Discrete Fourier Transform | Transformada Discreta de Fourier

def DFT(x):

N = x.shape[0]

# cria um vetor de N entradas complexas, preenchido com zeros

X = np.zeros(N, dtype='complex64')

n = np.array([p for p in range(N)]) # n = {0,1,2,...,N-1}

# Versão de "alta resolução" de n, usada para o gráfico apenas

Hn = np.linspace(0, N-1, 100*N) # Hn ={0,...,1,...,2,...,N-1}

for m in range(N): # m E {0,1,2,...,N-1}

C_Si = np.exp(-2 * np.pi * m * n / N * 1j) # C(m) - S(m) i

# Versão de "alta resolução" de C_Si, usada para o gráfico apenas

HC_Si = np.exp(-2 * np.pi * m * Hn / N * 1j)

X[m] = sum(np.multiply(x, C_Si)) # multiplicação termo a termo

# plotando:

plt.figure(1)

plt.suptitle('M =' + str(m), fontsize=16)

plt.subplot(211)

plt.plot(n,x[n].real, 'k:.', label='x[n]')

plt.plot(n,C_Si.real, 'k--o', label='C[n]')

plt.plot(Hn,HC_Si.real, 'k-',label='C[n] ideal')

plt.ylabel('Real', fontsize=14, color='k')

plt.subplot(212)

plt.plot(n,x[n].imag, 'k:.', label='x[n]')

plt.plot(n,C_Si.imag, 'k--o', label='C[n]')

plt.plot(Hn,HC_Si.imag, 'k-',label='C[n] ideal')

plt.ylabel('Imaginário', fontsize=14, color='k')

plt.legend()

plt.savefig('0' + str(m) + '.png', dpi=150)

plt.close('all')

#calcula o erro em relação ao algoritmo da biblioteca Scipy

error = sum((X-fft(x))**2)

print(round(error,5))

# retorna a parte não redundante da transformada

return X[0 : int(N/2+1)] if (N % 2 == 0) else X[0 : int((N+1)/2)]

def s(t):

return np.cos(2 * np.pi * t)

t = np.linspace(0, 1, 8) # 8 pontos entre 0 e 1

x = s(t) # aplica a função ponto a ponto

X = DFT(x)

# plotando:

plt.figure(1)

plt.subplot(211)

plt.ylabel('Real', fontsize=14, color='k')

plt.stem(X.real,linefmt='k--',markerfmt='ko', basefmt='k--')

plt.subplot(212)

plt.stem(X.imag,linefmt='k--',markerfmt='ks', basefmt='k--')

plt.ylabel('Imaginário', fontsize=14, color='k')

plt.savefig('transform.png', dpi=150)

plt.close('all')Implementação didática na linguagem Python do algoritmo DFT

Fonte: Elaboração própria

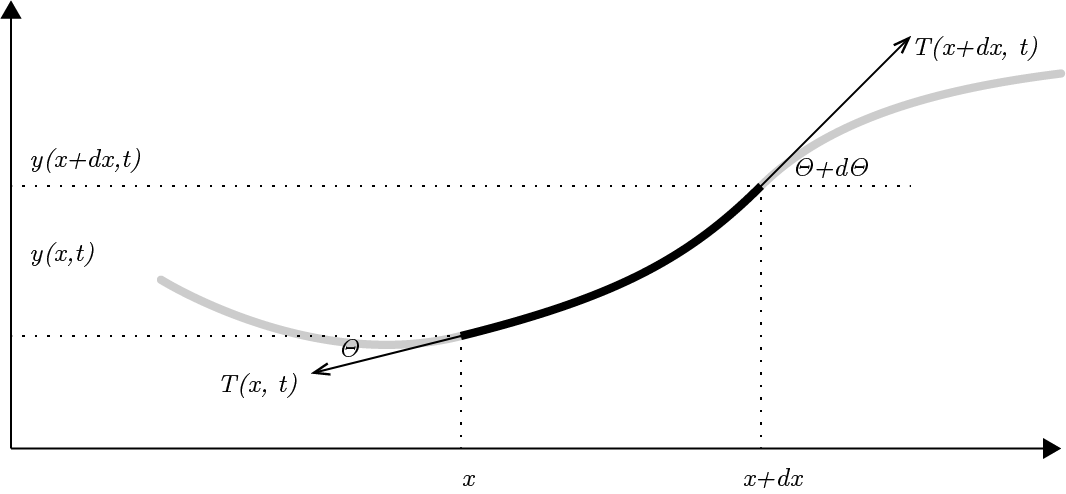

A equação diferencial que descreve o movimento de uma onda em duas dimensões pode ser derivada a partir das leis de Newton, assumindo algumas simplificações [@ garrett2017understanding]. Considerando a figura 18:

Fonte: Elaboração própria

e as seguintes definições:

\(y(x,t)\) a distância entre um ponto qualquer de uma corda e o eixo horizontal no tempo \(t\) e na posição \(x\);

\(\theta(x,t)\) o angulo entre a tangente da corda na posição \(x\) e no momento \(t\) e a direção horizontal;

\(\vec{T}(x,t)\) o vetor representando a tensão na corda, no ponto \(x\) e no momento \(t\);

Assumindo ainda que qualquer ponto da corda move-se somente na posição vertical temos que a resultante das forças é também vertical, e pode ser descrita como:

\[F(x,t) = T(x + dx,t)\sin(\theta + d\theta) - T(x,t)\sin(\theta) = T(x + dx,t)\cos(\theta + d\theta) \tan(\theta + d\theta) - T(x,t)\cos(\theta)\tan(\theta)\]

se considerarmos somente pequenos deslocamentos verticais da corda em relação à sua posição de equilíbrio, temos que \(\theta \ll 1\) e, portanto \(\cos(\theta + d\theta) \approx \cos(\theta) \approx 1\).

Além disso, lembrando que as tangentes podem ser escritas como a derivada parcial da função de deslocamento em relação à posição, temos:

\[F(x,t) = T(x+d x, t) \left(\frac{\partial y(x+d x)}{\partial x}\right) - T(x, t) \left(\frac{\partial y(x)}{\partial x}\right)\]

Assumindo tensão uniforme e invariável em toda a extensão da corda, condições bastante razoáveis no contexto de instrumentos musicais, podemos escrever \(T(x+d x, t) = T(x, t) = T\) e \(F(x,t)\) toma a forma $ T ( - )$, quando colocamos \(T\) em evidência. Se assumirmos que a massa do segmento infinitesimal da corda pode ser escrita na forma \(\rho dx\), onde \(\rho\) é a massa da corda por unidade de comprimento e \(dx \approx \sqrt{dx^2+dy^2}\) para oscilações pequenas, aplicando a segunda lei de Newton para força resultante na corda temos $F(x,t) = dx $.

Assim, temos $T ( - ) = dx $ que podemos reorganizar como \(\frac{\partial^2 y}{\partial t^2} = \frac{T}{\rho} \frac{\left(\frac{\partial y(x+d x)}{\partial x} - \frac{\partial y(x)}{\partial x}\right)}{dx}\). Notando que o termo à direita é a segunda derivada de \(y\) em relação a \(x\), chegamos à equação da onda:

\[\frac{\partial^2 y(x,t)}{\partial t^2} =\frac{T}{\rho} \frac{\partial^2 y(x,t)}{\partial x^2}\]

onde \(v = \sqrt{\frac{T}{\rho}}\) é a velocidade de propagação da onda na corda.

Uma solução para essa equação, quando não há uma fonte de excitação, foi proposta por d’Alembert (Chaigne e Kergomard, 2016), na forma:

\[y(x,t)=F(x+vt)-G(x-vt)\]

Essa equação pode ser intepretada como dois pulsos viajando em sentidos opostos em uma corda ideal com velocidade \(v\).

Em \(t=0\) podemos escrever:

\(y_0(x)=y(x,0)=F(x)-G(x)\)

\(v_0(x)=y'(x,0)=vF'(x)-vG'(x)\)

\(vF(x)-vG(x)= \int_{-\infty}^x v_0(\epsilon) d\epsilon\)

O que nos dá um sistema de equações que, resolvido, nos permite reescrever a equação de d’Alembert em função das condições iniciais de deslocamento e velocidade na corda, como abaixo:

\[y(x,t)= \frac{1}{2} \Big(y_0(x+vt)-y_0(x-vt) \Big) + \frac{1}{2v}\Big(\int_{x-vt}^{x+vt} v_0(\epsilon) d\epsilon \Big)\]

Essa formulação é importante já que em muitos casos pode-se trabalhar apenas com o deslocamento inicial da corda, o que torna o termo à direita zero.

Alternativamente, pelo método da separação de variáveis, pode-se obter a solução em termos de um soma infinita de senoides estacionárias(Gracia e Sanz-Perela, 2016):

\[y(x,t)= \sum_{n=1}^{\infty} \big(a_n \cos(2 \pi f_n t) + b_n \sin(2 \pi f_n t\big) \sin(\frac{n \pi x}{L})\]

onde considera-se uma corda de comprimento \(L\) fixa em suas extremidades. \(f_n\) são as frequências parciais da corda e são dados pela equação \(\frac{nv}{2l}\). Além disso, os coeficientes \(a_n\) e \(b_n\) são dados pelos coeficiente da trasformada de Fourier das condições iniciais em \(t=0\) (\(y_0(x)\) e \(v_0(x)\)) (Salsa, 2016)

essas duas interpretações dão origem às duas escolas distintas de modelagem acústica, como referido anteriormente, uma focada no domínio do tempo e outra no domínio da frequência. Repare, no entanto, que ambas as soluções modelam uma corda ideal, não levando em conta a rigidez encontrada em cordas reais.

No domínio do tempo, (Smith, 1992) aponta que a rigidez implica no fato de que ondas com diferentes frequências viajam através da corda em velocidades diferentes, relação regida por \(c(w) = c_0(\frac{1+kw^2}{2Kc_0^2})\) com \(k = E \pi r^4 \pi / 4\) onde \(E\) é o modulo de Young e \(r\) é o raio da corda.

No domínio da frequência (Rigaud, David e Daudet, 2013) demonstra que a rigidez pode ser incorporada ao modelo através da substituição do termo que descreve as frequências de cada parcial por \(fn = f_0 \sqrt{1 + Bn^2}\) onde \(f_0 = \frac{1}{2l} \sqrt{\frac{T}{\rho}}\) e \(B = \frac{\pi^3Ed^4}{64Tl^2}\) onde \(E\) é o modulo de Young e \(d\) é o diâmetro da corda.

A maneira mais simples de acomodar o decaimento devido à forças dissipativas, completando a teoria necessária ao presente trabalho, é modular as amplitudes em ambas as soluções a partir de um termo da forma \(e^{-\alpha t}\)

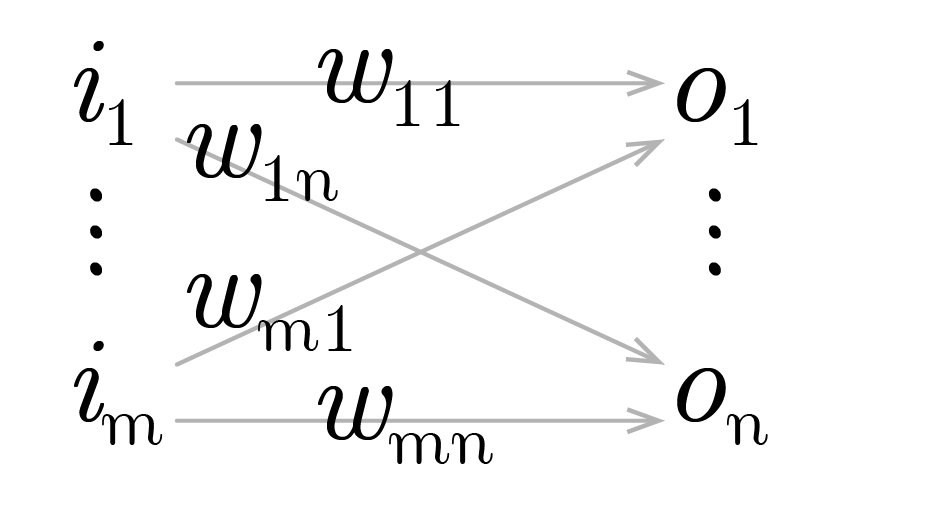

Definindo-se de maneira esquemática uma camada de uma rede neural artificial conforme a figura 19:

Fonte: Elaboração própria

Onde:

\(I_{1 \times m} := [i_1 \dots i_m]\) é um vetor de inputs à rede, e \(T_{1 \times n} := [t_1 \dots t_n]\)um vetor de alvos, de forma que para cada um dos ventores de input há um vetor de alvo correspondente, com a mesma dimensão da saída da camada;

\[ W_{m \times n} := \left[ \begin{matrix} w_{11} & \dots & w_{1n} \\ \vdots & \ddots & \vdots \\ w_{m1} & \dots & w_{mn} \end{matrix} \right] \]

é uma matriz representando os pesos das ligações entre os neurônios de entrada e saída, de forma que \(w_{ij}\) seria o peso da ligação entre o iésimo neurônio de entrada e o jésimo neurônio de saída.

\(A_{1 \times n} := [a_1 \dots a_n] \ |\ a_y := w_{1y}i_1 + \dots + w_{ny}i_n\)

representa cada elemento da multiplicação entre o vetor de entrada e os pesos da camada, antes da aplicação, elemento à elemento, da função de ativação;

\(O_{1 \times n} := [o_1 \dots o_n] \ |\ o_y := f(a_y) = f(w_{1y}i_1 + \dots + w_{ny}i_n)\)

é um vetor representando as saídas finais da camada;

\(E_{1 \times n} := [e_1 \dots e_n] \ |\ e_y := \varepsilon (o_y, t_y) = \varepsilon (f(w_{1y}i_1 + \dots + w_{ny}i_n) , t_y)\)

representa os erros individuais da rede para cada uma das saída motivadas por cada um dos inputs.

Cabe notar que \(\varepsilon (o_y, t_y) = (o_y - t_y)^2\) é a forma mais usual de computo dos erros individuais; define-se ainda o escalar \(q := e_1 + \dots + e_n\) como a soma dos erros individuais para cada um dos vetores de erros.

De posse das definições acima, somos capazes de representar de forma compacta, em notação matricial, o movimento de predição (forward pass) de uma camada, como será visto. E, por extensão, de uma rede, na medida em que estas podem ser obtidas pela justaposição de um número arbitrários de camadas.

O mesmo pensamento, de forma simétrica, presta-se à definição do movimento que atualizará os pesos (backward pass), e que é formalizado na próxima seção. Assim, derivaremos a seguir a forma básica do algoritmo de backpropagation.

Além de introduzir um referencial matemático para o algoritmo, isso permitirá que suas extensões, como Adam e Adagrad, utilizadas adiante, possam ser melhor compreendidas.

Tem-se que o gradiente do tensor de erros em relação a um peso arbitrário de uma camada pode ser escrito como na equação 6, com aplicação direta da regra da cadeia, e observando a seguinte notação para uma função qualquer \(h(x)\) : \(\frac{\partial}{\partial x}h(x) = h'(x)\).

\[ \frac{\partial q }{\partial w_{xy}} = \varepsilon' (o_y, t_y) f'(a_y)i_x \quad \text{Eq.:(I)} \](6)

A matriz de incrementos para cada um dos pesos, a cada iteração, pode ser definida como abaixo, com a adição de uma taxa de aprendizado \(\alpha\) com sinal negativo. Assim é, uma vez que o gradiente acima aponta para sentido de maior crescimento dos erros no espaço dos pesos: minimizar os erros implica, portanto, em mover os pesos em sentido oposto.

\[ \Delta W_{m \times n} := \left[ \begin{matrix} \Delta w_{11} & \dots & \Delta w_{1n} \\ \vdots & \ddots & \vdots \\ \Delta w_{m1} & \dots & \Delta w_{mn} \end{matrix} \right] \ |\ \Delta w_{xy} := - \alpha \frac{\partial q}{\partial w_{xy}} = - \alpha \varepsilon' (o_y, t_y) f'(a_y)i_x \]

Resta definir uma forma de propagar os erros às entradas da rede, permitindo assim que um número arbitrário de camadas sejam conectadas e treinadas. Para tanto, convém considerar uma camada anterior à rede em tela, com a forma e notação apresentadas na figura 20:

Fonte: Elaboração própria

E, de forma análoga:

\[ \begin{align} Z_{1 \times m} :=& [z_1 \dots z_m] \ |\ z_x := u_{1x}p_1 + \dots + u_{kx}p_k \\ I_{1 \times m} =& [i_1 \dots i_m] \ |\ i_x := g(z_x) = g(u_{1x}p_1 + \dots + u_{kx}p_k) \end{align} \]

\[ \begin{align} \frac{\partial q}{\partial u_{rx}} =& [ \varepsilon' (o_1, t_1) f'(a_1) w_{x1} g'(z_x)p_r + \dots + \varepsilon' (o_n, t_n) f'(a_n) w_{xn} g'(z_x)p_r ] \\ =& [ \varepsilon' (o_1, t_1) f'(a_1) w_{x1} + \dots + \varepsilon' (o_n, t_n) f'(a_n) w_{xn} ] g'(z_x)p_r \end{align} \]

Comparando com \(\text{I}\) é fácil observar que o somatório na primeira parte da última expressão corresponde a derivada do erro na primeira equação. Assim, Podemos definir o tensor do erro propagado da forma apresentada abaixo:

\[ \begin{align} E_{1 \times m}^b :=& [e_1^b \dots e_m^b] \ |\ e_x^b := \varepsilon' (o_1, t_1)f'(a_1)w_{x1} + \dots + \varepsilon' (o_n, t_n) f'(a_n)w_{xn} \end{align} \]

Fixamos, dessa forma, todos os termos necessários à uma arquitetura modular: para camadas ocultas, para as quais não há como aferirmos diretamente o erro, o mesmo é propagado a partir das camadas posteriores. Em forma vetorial, pode-se sintetizar o algoritmo como na equação 7, observando a conveniência de introduzirmos o tensor \(H_{1 \times n}\) para evitar redundância nos cálculos, e a notação \(\odot\) denotando o produto de Hadamard (elemento a elemento) entre dois tensores:

\[ \begin{align} O =& f(IW) \\ H_{1 \times n} :=& E \odot f'(A)\\ \Delta W =& -\alpha I^t H= - \alpha I^t (E \odot f'(A)) \\ E^b =& HW^t= (E \odot f'(A)) W^t \end{align} \](7)

Para a busca da coleção de amostras sonoras a serem utilizados para o treinamento da rede, algumas características são essenciais. Em primeiro lugar, uma licença permissiva, que não limite a utilização, modificação e posterior divulgação dos resultados obtidos deve ser explicitamente atribuída pelo autor.

Além disso, para o caso da bateria, todas as peças de um kit ordinário devem estar presentes, e idealmente, organizadas de maneira inteligível, enquanto que para instrumentos temperados é bastante útil algum tipo de indicação da frequência fundamental de cada uma das amostras.

É desejável também que, para cada peça, amostras representando várias dinâmicas tenham sido gravados, com especial atenção à intensidade com que cada peça é golpeada. Interessante ainda é a presença dos chamados round-robins: gravações redundantes de cada uma das amostras, que apresentam uma ideia de como fatores aleatórios influenciam no som produzido pelo instrumento.

Com isso em mente, procedeu-se à busca, em sites e blogs especializados, de indicações sobre trabalhos disponíveis que pudessem enquadrar-se nas condições citadas. No caso do kit de bateria, dois trabalhos em especial foram considerados:

O primeiro é um esforço de disponibilizar, através da plataforma Github, uma coleção livre de sons de bateria. O trabalho leva o nome de The Open Source Drumkit (Crabacus, 2015) em consiste em uma coleção de amostras em formato .wav, separadas em pastas e nomeadas de acordo com a intensidade do golpe, e as peças específicas de um kit de bateria convencional, apresentando uma média de 10 articulações por peça.

O segundo é um esforço para a elaboração de um instrumento virtual de bateria denominado DrumGizmo (“DrumGizmo Wiki”, [s.d.]), e apresenta samples gravadas a partir de 5 kits físicos de bateria. O número de articulações é bem maior, girando em torno de 20 por kit, e as gravações apresentam múltiplos microfones, com pelo menos um microfone por peça e são, em geral, de melhor qualidade. Além disso, a maioria dos kits adere à licença Creative Commons Attribution 4.0 International que permite o livre uso e adaptação do material disponibilizado em trabalhos derivados.

No caso das amostras de piano, em (“Ivy Audio”, [s.d.]) pode ser encontrado, entre outros, um DMI baseado em samples de um Steinway Model B grand piano, com 5 dinâmicas e 2 round-robins para cada tecla, além de um total de 4 condições de microfonação. Detalhes dos termos de uso são discutidos na página de FAQ do site.

No site do University of Iowa Electronic Music Studios (“Musical Instrument Samples”, [s.d.]) um conjunto bastante semelhante de amostras do mesmo piano pode ser encontrado, com a vantagem de uma atribuição mais livre de condições de uso; as amostras, no entanto, diretamente hospedadas no site, devem ser baixadas uma por vez.

Uma vasta gama de amostras sonoras de instrumentos clássicos, com variadas dinâmicas, é oferecida no site da Philharmonia Orchestra (“Sound Samples”, [s.d.]).

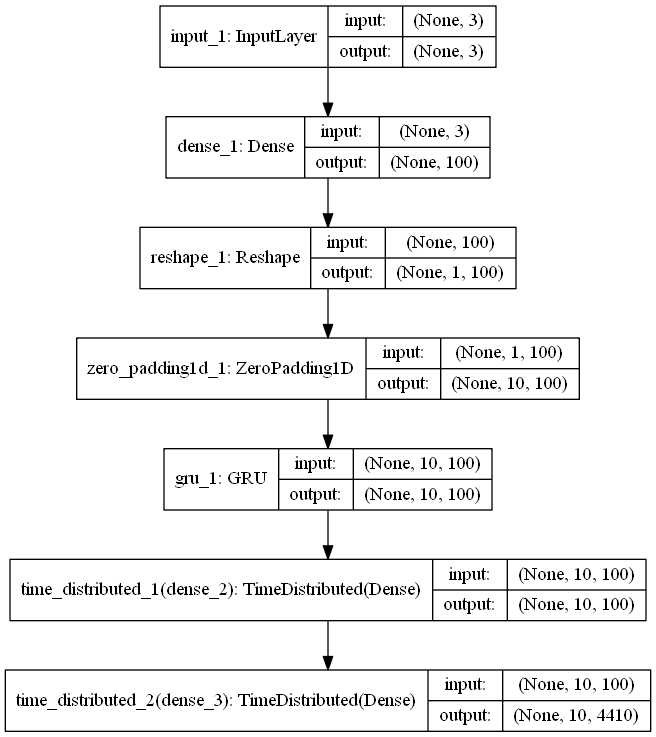

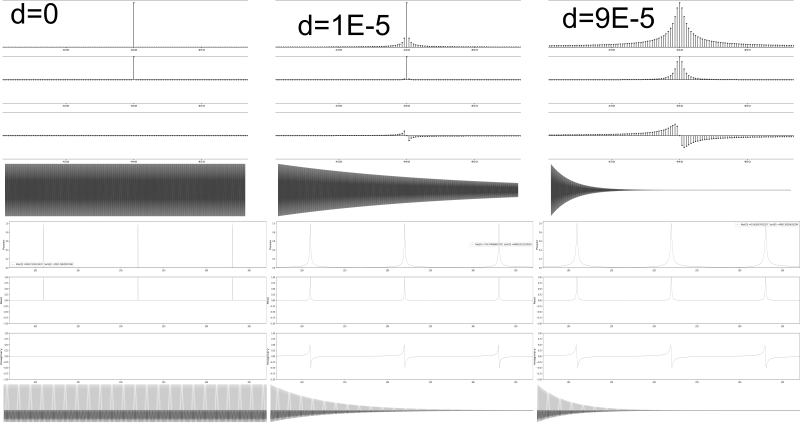

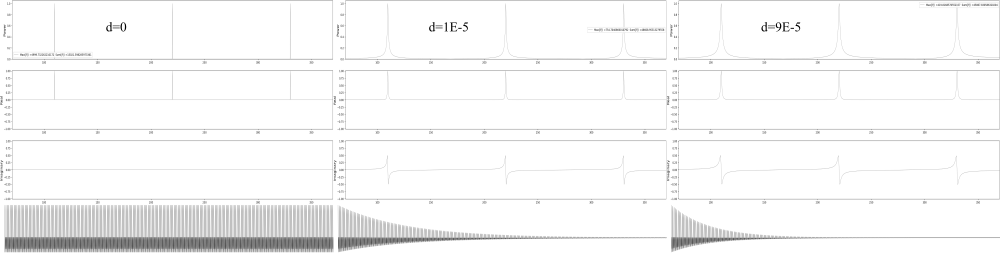

É natural que a investigação tenha início com uma análise da arquitetura Feed-Forward, com redes compostas de um número arbitrário de camadas totalmente conectadas. Isso possibilita formar uma ideia de como essa arquitetura básica se comporta em um ambiente de alta dimensionalidade, pavimentando o caminho para a subsequente incorporação de novas arquiteturas e formulações na medida em que limites de aplicabilidade forem sendo encontrados.

Convém lembrar que o trabalho tem como foco a síntese sonora em tempo real, de forma que o tamanho, no sentido do número de neurons de uma rede neural, e sua complexidade, aspecto relacionado à arquitetura, tornam-se fatores potencialmente limitantes, e passam a requerer especial atenção. Redes convolucionais, por exemplo, devem ser tratadas com extrema cautela, por não possuírem um histórico de implementações eficientes.

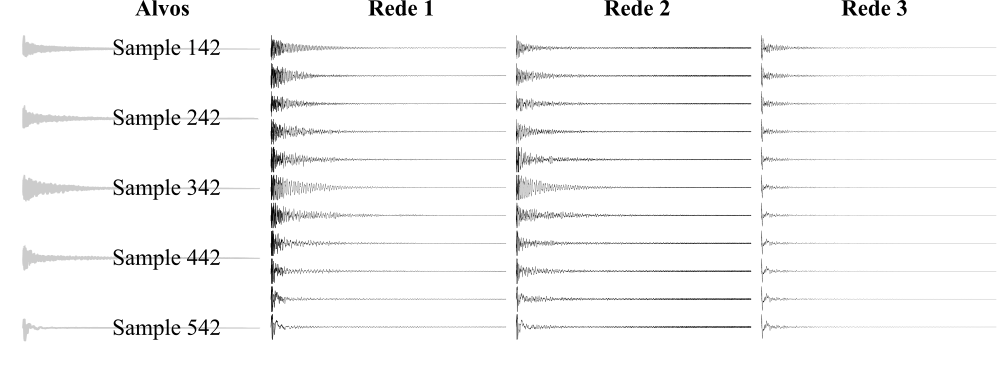

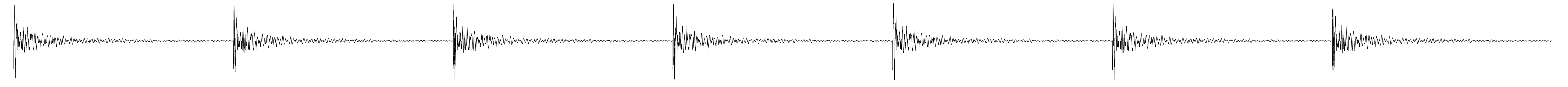

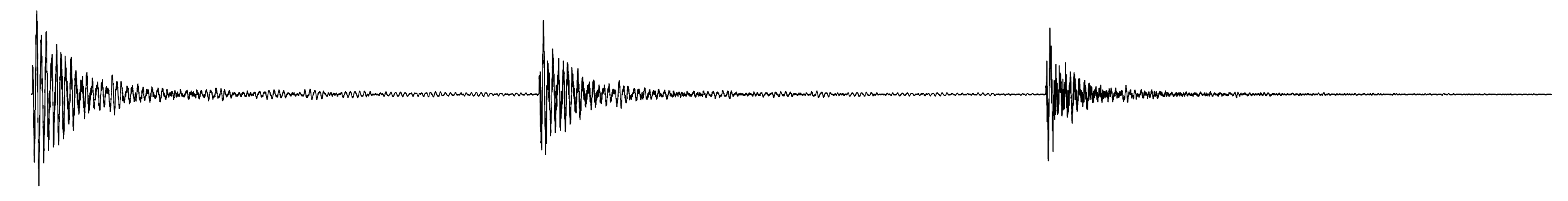

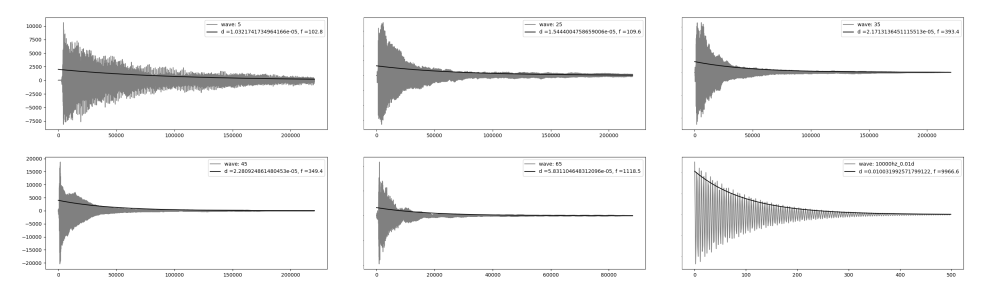

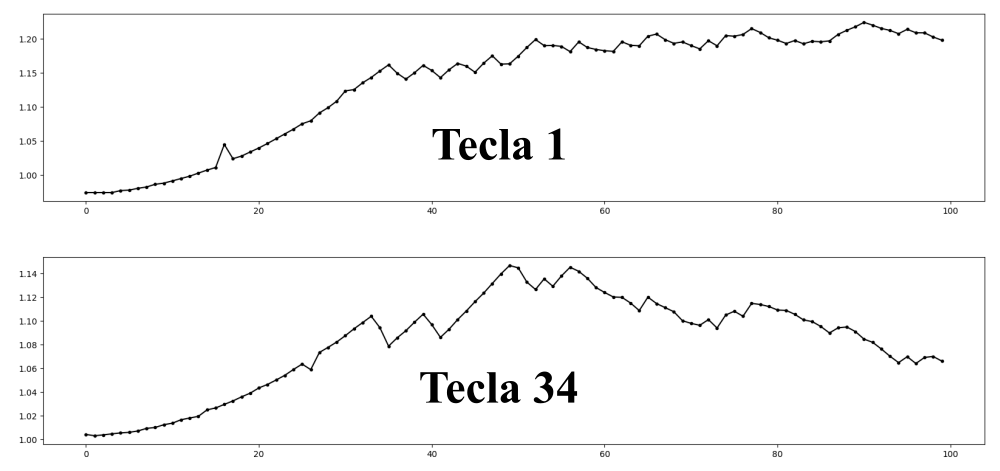

Em primeiro lugar, procedeu-se ao tratamento dos samples: foram escolhidos, para esta investigação inicial, 5 tambores (os 4 tons disponíveis, e o bumbo esquerdo) do kit denominado Aasimonster disponibilizado pela iniciativa DrumGizmo, de cada um dos quais 20 dinâmicas foram escolhidas, gerando um total de 100 amostras, cada um com 16 canais (1 por microfone utilizado na gravação).

foram extraídos os canais pertinentes à cada peça, resultando em 100 samples monofonicos em formato .wav, com framerate de 44100 frames por segundo. As dinâmicas para cada peça foram normalizadas em grupos de 4, de forma a emular 4 samples redundantes (round-robins) para 5 níveis diferentes de intensidade por peça. Cada uma das amostras foi truncada, para possuir exatamente um segundo de duração, e um efeito fade-off foi aplicado às amostras que estendiam-se além desse intervalo.

Esse conjunto de samples, de forma bastante direta, representou os alvos da rede neural, na forma de um vetor de dimensão 100 x 44100, como cada uma de suas linhas consistindo em uma representação digital da onda sonora de cada amostra. A conversão foi efetuada utilizando o módulo Pywave da linguagem Python, e cada vetor foi normalizado no espaço [-1,1]. Os samples foram renomeados de forma a serem mais descritivos.

Exemplificando, temos que a amostra de rótulo 154, corresponde à quarta amostra redundante referente à primeira peça (o tom mais agudo), golpeada com intensidade 5 (maior intensidade). Assim, as amostras 321, 322, 323 e 324, por exemplo, correspondem à quatro variações do mesmo evento: cada um deles representa a terceira peça golpeada com intensidade 2. Os dados de entrada da simplesmente refletem essa nomenclatura em um intervalo [0,1] e são apresentados na tabela 2.

| Peça | Peça Norm. | Intensidade | Intensidade Norm. | Sample # | Sample # Norm. |

|---|---|---|---|---|---|

| 1 | 0.00 | 1 | 0.00 | 1 | 0.00 |

| 2 | 0.25 | 2 | 0.25 | 2 | 0.33 |

| 3 | 0.50 | 3 | 0.50 | 3 | 0.66 |

| 4 | 0.75 | 4 | 0.75 | 4 | 1.00 |

| 5 | 1.00 | 5 | 1.00 | - | - |

Fonte: Elaboração própria

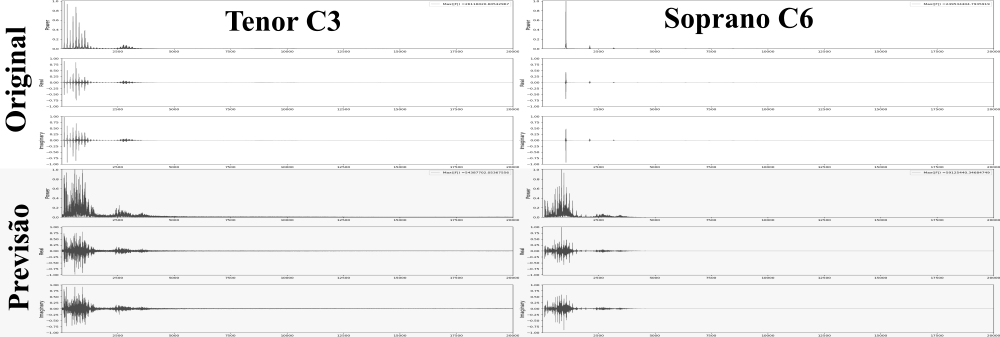

O que pretende-se é forçar uma associação de cada uma das características da onda à cada uma das 3 dimensões do vetor de entrada. Esse rationale tem algumas implicações importantes: critérios de validação, embora possíveis de construir, perdem bastante do seu significado e foram deixados de lado em favor de um julgamento subjetivo da qualidade das amostras geradas.

Utilizando as 100 amostras, processados como descrito, como alvos, e seus rótulos normalizados como entradas, buscou-se investigar os hiperparâmetros de uma rede neural densa mais adequados ao apredizado e reprodução das ondas; essa é uma etapa importante, pois vários parametros aqui definidos serão assumidos como ótimos e utilizados em etapas posteriores, em arquiteturas diferentes.

Essa necessidade tem origem nas restrições de tempo e poder computacional, que impedem a realização de novos testes dessa magnitude para cada uma das arquiteturas futuramente investigadas. A plataforma escolhida para a implementação das redes foi o Keras, rodando com o Tensorflow como backend. Essa escolha permite aproveitar a velocidade de experimentação conferida pela arquitetura em nível mais alto da biblioteca Keras sem comprometer muito a flexibilidade.

Em primeiro lugar, é conveniente investigar o melhor algoritmo de atualização dos pesos: embora, conceitualmente, mesmo a versão pura da descida em gradiente, utilizando uma taxa de aprendizado adequada, leve à eventual convergência da rede (Ruder, 2016), na prática a velocidade dessa convergência varia consideravelmente dependendo do método utilizado, e um algoritmo eficiente permite a realização de mais testes no mesmo intervalo de tempo.

A literatura disponível, embora esclarecedora, não é unanime ao apontar uma técnica universalmente superior às outras, de forma que uma investigação empírica faz-se necessária, e é descrita a seguir.

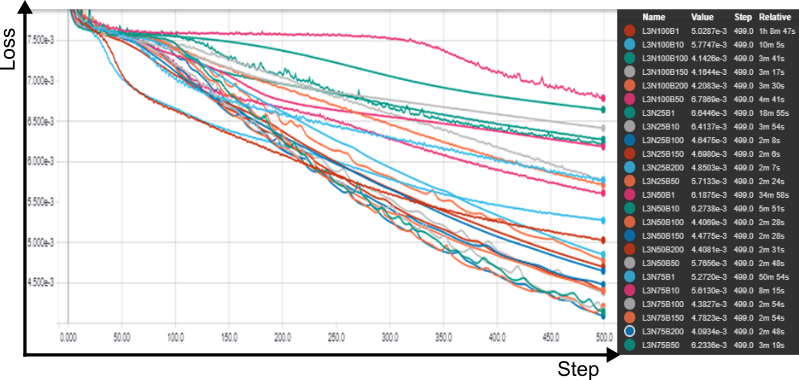

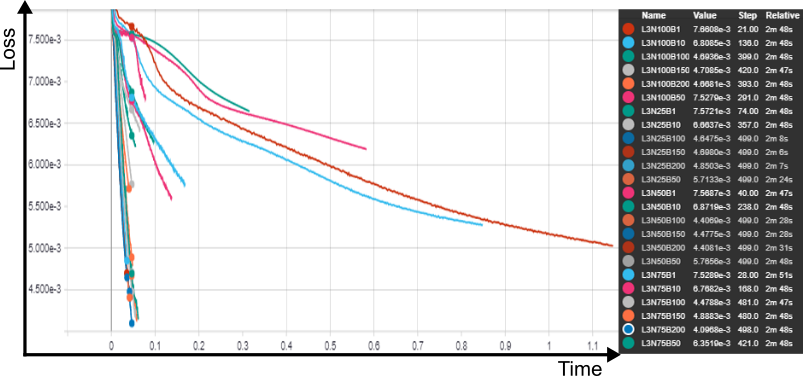

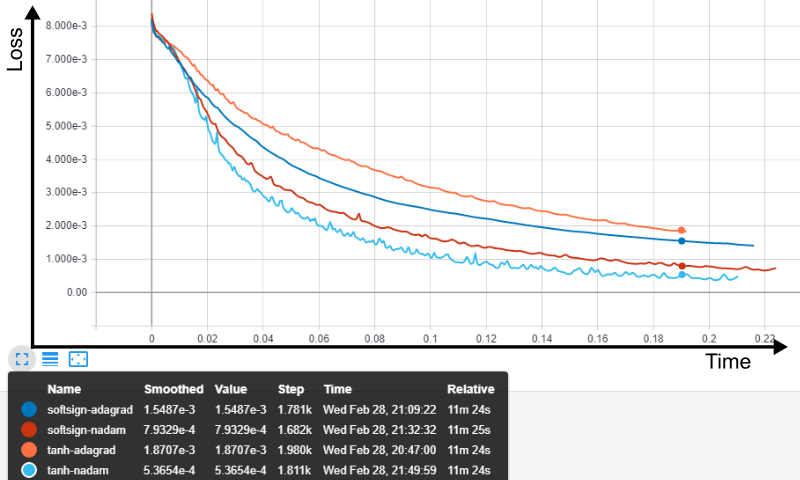

testou-se, em uma rede com uma camada oculta composta por 100 neurons, em lotes (batches) de 100 vetores de entrada e durante 500 épocas os seguintes algoritmos de otimização: SGD com uma learning rate de 0,01, o algoritmo experimental RMSProp (Tieleman e Hinton, 2012), os otimizadores Adam (Kingma e Ba, 2014; Reddi, Kale e Kumar, 2018), Adagrad (Duchi, Hazan e Singer, 2011), Adadelta (Zeiler, 2012), Adamax(Kingma e Ba, 2014) e Nadam (Dozat, 2016; Sutskever et al., 2013). A função de ativação utilizada em todas as camadas foi a tangente hiperbólica, e a função de perda foi a média dos quadrados dos erros. Foi tomado cuidado para que todos os testes iniciassem em condições pseudo-randomicas idênticas.

SGD e Adadelta ofereceram resultados bastante semelhantes, e aquém dos outros. Todos os outros convergiram de forma semelhante, sendo o Adagrad o mais rápido de todos, e Nadam o mais eficaz na diminuição da função de perda.

A comparação por tempo relativo, disponível a partir do Tensorboard, permite visualizar a superioridade do algoritmo Nadam: com 2,57 minutos de treino, o tempo em que o treinamento foi concluído com o algoritmo Adagrad, ele proporcionou o menor valor da função objetivo.

Convém investigar, dessa forma, o comportamento da rede treinada com ambos os algoritmos, já que o parâmetro mais importante é a rapidez com que a rede alcança um nível de erro capaz de gerar samples com qualidade satisfatória. Após essa comparação exploratória, mais profunda, poderemos identificar tanto o valor limite da função de perda, quanto o tempo em que a rede mais eficiente leva para alcançá-lo, utilizando essas informações como parâmetros para investigações posteriores, inclusive de outras arquiteturas.

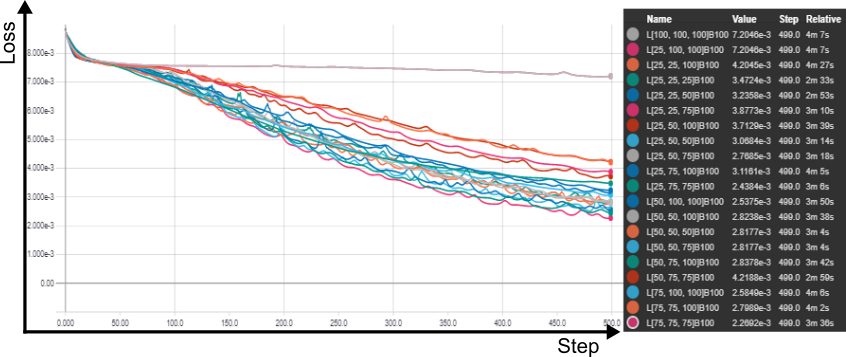

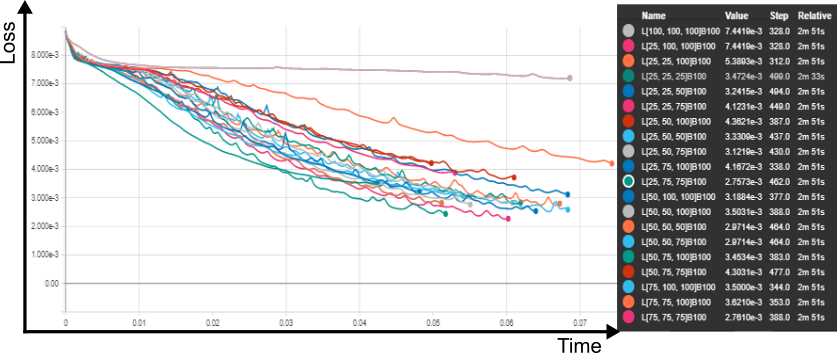

Fixado os potenciais algoritmos de otimização, procedeu-se a um grid search, para investigar o número de camadas ocultas, respectivos neurons e o efeitos dos tamanhos dos batchs , tanto em relação ao impacto no tempo total de treinamento quanto à rapidez (e limite) de convergência.

Testou-se batches de 1, 10, 50, 100, 150 e 200 samples para redes com 25, 50, 75 e 100 neurônios em cada camada oculta, em um intervalo de 0 a 3 camadas ocultas, gerando um total de 82 redes distintas, que foram treinadas durantes 500 épocas.

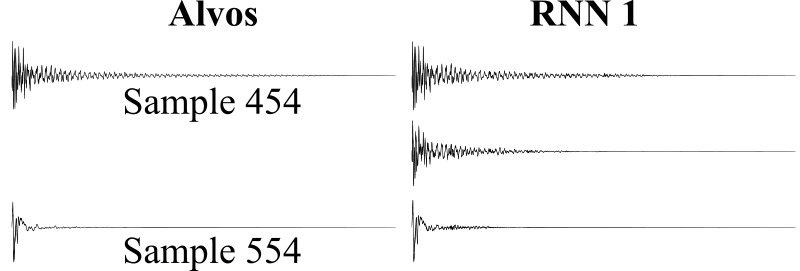

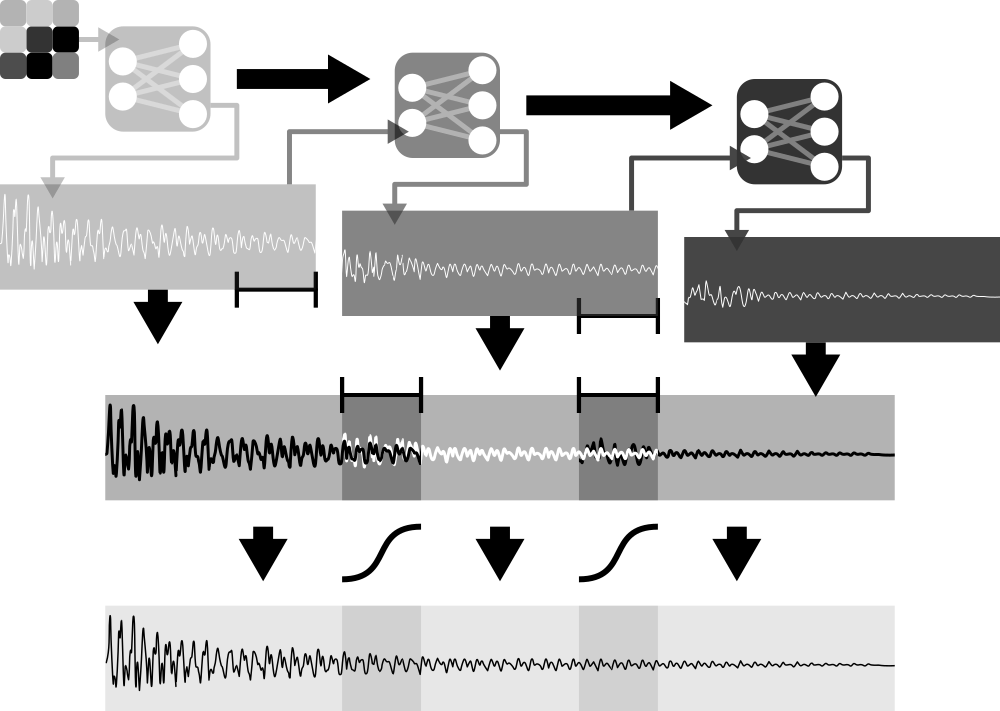

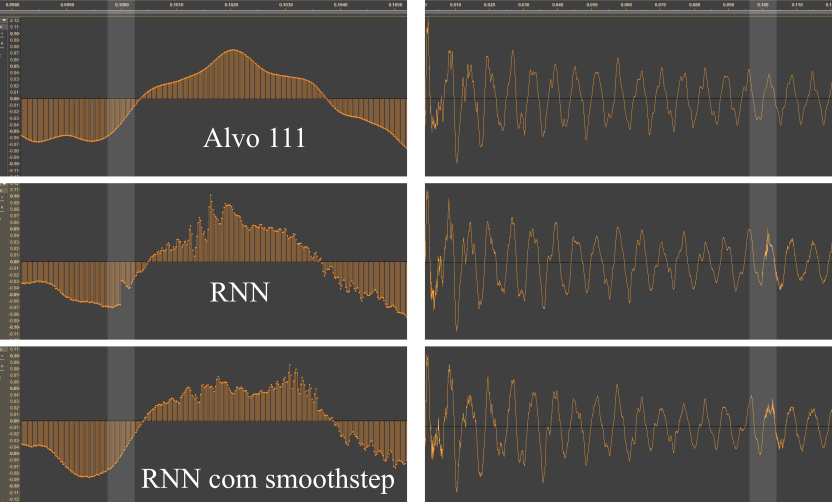

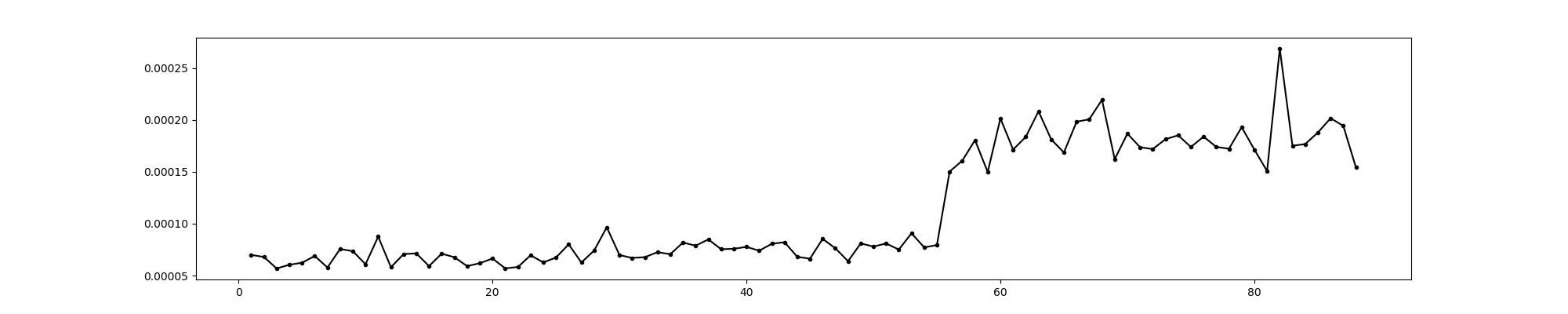

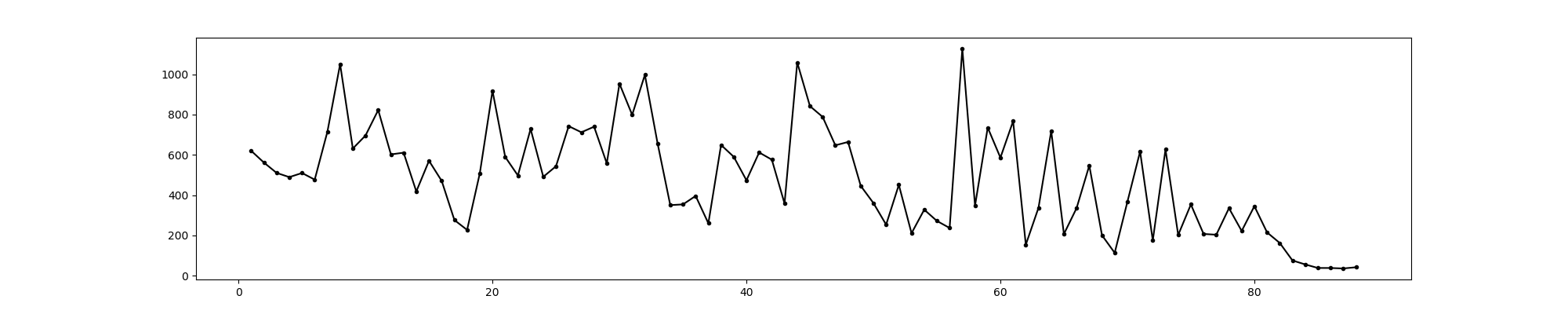

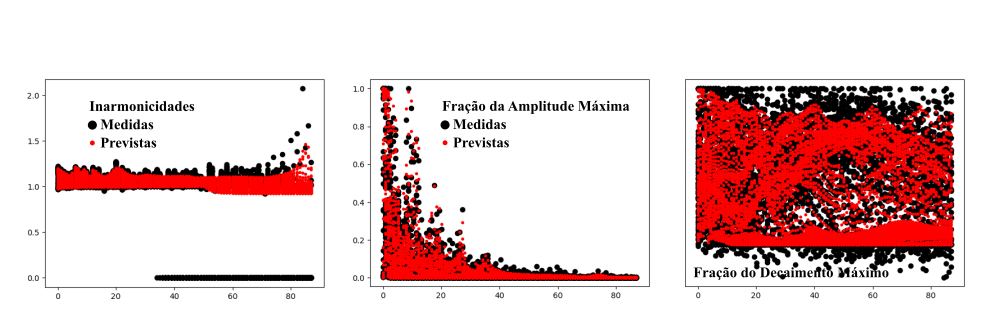

Para uma rede sem camadas ocultas, um batch igual a 1 foi o mais efetivo, em 500 épocas, porém o mais lento. batches de 100 e 50 foram os mais rápidos. O impacto no valor final da perda, no entanto, foi desprezível para todos os tamanhos de batches. para um camada oculta com 25 neurons, batches de 100 e 150 neurons ofereceram resultados idênticos, sendo os mais rápidos e mais eficientes.